- Home

- Entwickler

- Was ist HTTP/2 und wie es zur Beschleunigung von Websites beiträgt

Inhaltsverzeichnis

- Entwicklungsgeschichte von HTTP/2

- Probleme und Einschränkungen von HTTP/1.1

- Die Leistungsfähigkeit von HTTP/2: wie es Websites beschleunigt und die Datenübertragung verbessert

- Wie HTTP/2 Websites in der Praxis schneller macht

- Ziehen wir Bilanz

Testen Sie das Gcore Netzwerk

Jetzt kostenlos testenHTTP (HyperText Transfer Protocol) ist ein Netzwerkprotokoll auf Anwendungsebene, das festlegt, wie Inhalte über das Internet übertragen werden. HTTP/2 ist die neueste Version zum Zeitpunkt dieser Veröffentlichung.

Entwicklungsgeschichte von HTTP/2

Die erste Version des Protokolls, HTTP/0.9, wurde 1991 veröffentlicht. 1996 kam HTTP/1.0. Und der Vorgänger von HTTP/2 war HTTP/1.1, das 1999 veröffentlicht wurde. Danach gab es lange Zeit keine Aktualisierungen mehr.

Eine Alternative zu HTTP/1.1 wurde im Jahre 2009 entwickelt. Es war das SPDY-Protokoll. Die Entwickler erkannten, dass die bestehende Version keine ausreichende Datenübertragungsgeschwindigkeit bot. Ziel war es, die Art und Weise, wie die Software Anfragen empfängt und sendet, zu ändern und so das Internet zu beschleunigen. Aus diesem Protokoll ist HTTP/2 hervorgegangen.

SPDY beschleunigte die Webanwendungen tatsächlich, gewann an Popularität und wurde zu einem ernsthaften Konkurrenten von HTTP. Schließlich beschlossen die Entwickler, dass es nicht zwei konkurrierende Protokolle geben sollte, und kombinierten die beiden. Die Arbeitsgruppe HyperText Transfer Protocol des Internet Engineering Board übernahm die Aufgabe, das neue Protokoll zu erstellen. So wurde HTTP/2 im Jahre 2015 geboren.

Das Hauptziel der neuen Version war die Beschleunigung der Datenübertragung. Gleichzeitig wollten die Entwickler die Engpässe von HTTP/1.1 beseitigen, um es produktiver und sicherer zu machen.

Probleme und Einschränkungen von HTTP/1.1

Wie bereits erwähnt, wurde diese Version des Protokolls im Jahre 1999 veröffentlicht. HTTP/2 kam nur 16 Jahre später. In dieser Zeit hat sich im Internet viel verändert, die Websites haben neue Elemente: jР В°vascript, Animationen, CSS-Stile und vieles mehr.

Damit die Web-Ressourcen schnell genug geladen werden konnten, mussten die Anfragen für verschiedene Elemente gleichzeitig bearbeitet werden. Das Protokoll musste mehrere TCP-Verbindungen auf einmal aufbauen, um verschiedene Arten von Daten zu übertragen.

Dies führte zu einer enormen Belastung des Netzes.

Gleichzeitig war die Zahl der bestehenden Verbindungen begrenzt und oft unzureichend. Um diese Beschränkungen zu umgehen, haben Webentwickler viele verschiedene Tricks angewandt, z.B. Domain-Sharing (Verwendung von Subdomains zum Hochladen von Ressourcen), Zusammenführen von Bildern in eine einzige Datei usw. Dies führte zu zusätzlichen Komplikationen.

Da HTTP/1.1 bereits seit vielen Jahren im Einsatz war, erfüllte es irgendwann die Sicherheitsanforderungen nicht mehr. Angreifer fanden darin Schlupflöcher, die es ihnen ermöglichten, Benutzerdaten zu stehlen.

HTTP/2 hat all diese Probleme gelöst und zur Beschleunigung der Datenübertragung im Internet beigetragen.

Die Leistungsfähigkeit von HTTP/2: wie es Websites beschleunigt und die Datenübertragung verbessert

Um alle Probleme zu beheben, die HTTP/1.1 hatte, haben die Entwickler einige wichtige Änderungen vorgenommen. Wir werden nicht auf alle Unterschiede eingehen, sondern nur auf die, die sich direkt auf die Geschwindigkeit auswirken.

Binäres Protokoll

Frühere Versionen von HTTP übermittelten Daten im Textformat. Das war für die Nutzer praktisch. Aber technisch gesehen waren Textnachrichten langsamer zu verarbeiten als binäre Nachrichten.

Bei HTTP/2 bestehen die Nachrichten aus Frames, also binären Dateneinheiten. Ihre Gesamtheit wird als Strom bezeichnet. Jeder Frame trägt eine eindeutige Streamkennung — Informationen darüber, zu welchem Stream er gehört.

Es gibt verschiedene Arten von Frames. Für die Übertragung von Metadaten (Größe der Nachricht, Datentyp, Absender- und Empfängeradresse usw.) wird beispielsweise der HEADERS-Frame verwendet, für die Hauptnachricht der DATA-Frame.

Es gibt einen RST_STREAM-Frame — er wird zur Unterbrechung des Streams verwendet. Der Client sendet diesen an den Server, um ihm mitzuteilen, dass der Stream nicht mehr benötigt wird. Dadurch wird die Datenübertragung gestoppt, aber die Verbindung bleibt offen. Im Vergleich dazu: Bei HTTP/1.1 war die einzige Möglichkeit, die Datenübertragung zu stoppen, die Unterbrechung der Verbindung, die dann neu geöffnet werden musste.

Dieses Prinzip des Binärprotokolls verbessert die Qualität der Verbindung:

- Die Fehlerwahrscheinlichkeit ist geringer.

- Der Aufwand für das Parsen von Daten wird reduziert.

- Die Belastung des Netzes wird verringert und die Ressourcen werden effizienter genutzt.

- Binäre Befehle sind kompakter als Textbefehle, was die Verarbeitungs- und Ausführungszeit verkürzt.

- Dadurch werden Verzögerungen bei der Datenübertragung verringert.

- Eine einfachere Verarbeitung von Nachrichten bedeutet eine höhere Fehleranfälligkeit.

- Das Risiko von Hackerangriffen, insbesondere von Angriffen wie dem HTTP Response Splitting, wird verringert. In früheren Versionen waren solche Angriffe auf Textdaten in den Kopfzeilen möglich.

Darüber hinaus eröffnet die binäre Natur von HTTP/2 eine Reihe von Möglichkeiten zur Beschleunigung der Datenübertragung, auf die wir gleich noch eingehen werden.

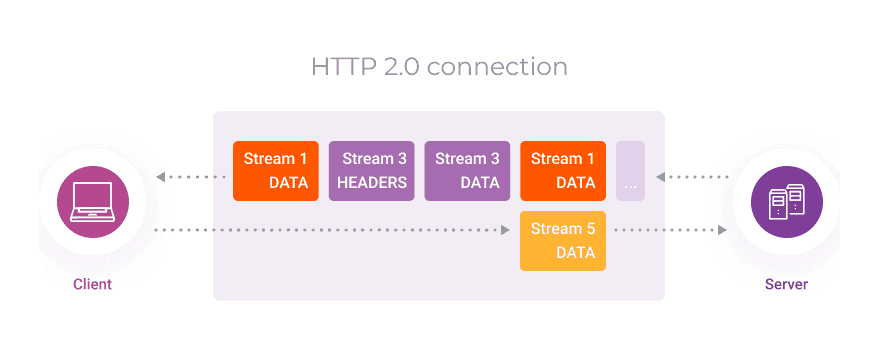

Multiplexing

Dies ist einer der Hauptunterschiede zwischen HTTP/2 und früheren Versionen. Dadurch wurde es möglich, die Geschwindigkeit der Datenübertragung zu erhöhen.

In HTTP/1.1 wurden zur schnellen Übertragung verschiedener Datentypen mehrere parallele TCP-Verbindungen eingerichtet. In der neuen Version können alle Daten über eine einzige Verbindung übertragen werden.

Die binäre Natur des Protokolls erlaubt es, verschiedene Informationen parallel herunterzuladen, ohne dass es zu Verzögerungen oder Blockierungen bei den Antworten oder Anfragen kommt.

Da nur eine einzige Verbindung aufgebaut werden muss, wird die Zeit für die Bereitstellung der Inhalte erheblich verkürzt. Jede TCP-Verbindung erfordert nämlich einen „dreifachen Handschlag“:

- Der Absender sendet eine Anfrage zum Aufbau einer Verbindung — eine SYN-Nachricht und die Ordnungsnummer des übertragenen Bytes.

- Der Empfänger antwortet mit einer SYN-Nachricht, bestätigt den Empfang der Daten mit einer ACK-Nachricht und sendet die Nummer des als nächstes zu empfangenden Bytes.

- Der Absender bestätigt ebenfalls, dass er die Information erhalten hat und sendet die Nummer des nächsten zu empfangenden Bytes.

Erst nach diesen drei Schritten gilt die Verbindung als hergestellt.

All diese Schritte nehmen Zeit in Anspruch. Wenn eine Verbindung nur einmal aufgebaut werden muss, wird keine Zeit mit unnötigen „Handschlägen“ verschwendet und somit die Geschwindigkeit erhöht.

Darüber hinaus ist bei HTTP/2 keine Domänenaufteilung erforderlich.

Um das HTTP/1.1-TCP-Verbindungslimit zu umgehen, haben die Entwickler einige Inhalte in Subdomains verschoben. Die Daten aus den Subdomains wurden parallel heruntergeladen, was die Geschwindigkeit erhöhte.

Dies ist jetzt nicht mehr nötig, da verschiedene Daten über dieselbe Verbindung übertragen werden und es keine Einschränkungen gibt.

Komprimierung von Kopfzeilen

Damit ein Server eine Anfrage so genau wie möglich ausführen kann, muss ihre Kopfzeile so viele detaillierte Metadaten wie möglich enthalten. Und HTTP ist ein nicht zustandsorientiertes Protokoll. Das bedeutet, dass der Server keine Informationen aus früheren Anfragen speichern kann und dass der Client daher jedes Mal viele sich wiederholende Daten in den Kopfzeilen senden muss.

Die Kopfzeilen sind etwa 500–800 Byte groß, und manchmal mehr als ein Kilobyte, wenn Cookies verwendet werden.

Dadurch wird die gesamte Nachricht größer. Und je größer die Datenmenge ist, desto länger dauert die Übertragung und desto größer ist die Verzögerung.

HTTP/2 löst dieses Problem durch Komprimierung der Kopfzeilen mit dem HPACK-Format. Р С›Es kodiert und komprimiert Kopfzeilen mit dem Huffman-Algorithmus. Gleichzeitig unterhalten Client und Server eine gemeinsame, ständig aktualisierte Tabelle der Kopfzeilen. Dadurch können die Kopfzeilen anhand einer Tabelle rekonstruiert werden, anstatt sie wiederholt zu übermitteln.

Es werden weniger Daten übertragen, so dass Anfragen und Antworten schneller erfolgen.

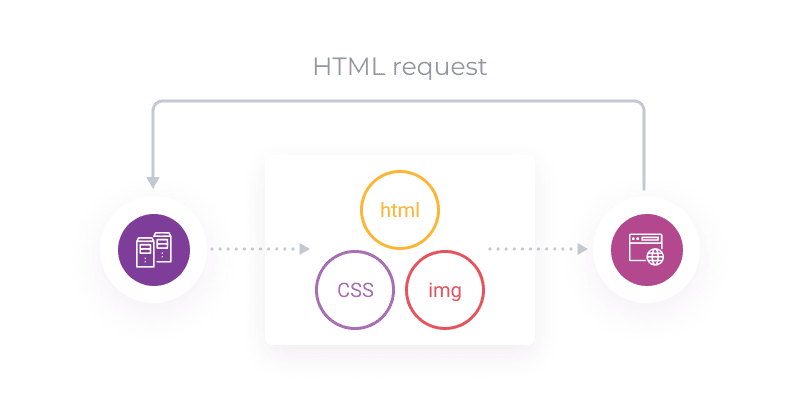

Server-Push-Funktion

Diese Funktion ermöglicht es dem Server, Daten zu übermitteln, bevor der Client sie überhaupt angefordert hat. Zum Beispiel lädt der Browser eine Seite und sendet eine HTML-Anfrage. Neben dem HTML-Code benötigt die Seite aber auch CSS, um sie zu rendern. Der Server wartet nicht auf eine zweite CSS-Anforderung, sondern sendet die Daten zusammen mit dem angeforderten CSS.

Die vom Server „erratenen“ Daten werden mit dem Frame PUSH_PROMISE gesendet. Auf diese Weise kann der Kunde erkennen, dass es sich um Informationen handelt, die nicht angefordert wurden, und feststellen, ob sie benötigt werden. Wenn die Daten nicht benötigt werden (z.B. weil sie sich bereits im Cache befinden), kann der Browser mit einem RST_STREAM-Frame antworten (wie oben beschrieben) und die Redundanzübertragung beenden.

Auf diese Weise lassen sich doppelte Informationen vermeiden.

Auf diese Weise reduziert die Funktion die Anzahl der Anfragen an den Server, verringert die Belastung des Servers und beschleunigt die Webanwendungen.

Prioritätensetzung bei der Bereitstellung von Inhalten

Daten werden bei HTTP/2 standardmäßig asynchron in beliebiger Reihenfolge übertragen. Diese Reihenfolge kann jedoch festgelegt werden. Sie können festlegen, welche Daten der Server zuerst senden soll und welche später gesendet werden können.

Das Protokoll ermöglicht es Ihnen, die Gewichtung der einzelnen Streams zu bestimmen, d. h. ihre Bedeutung im Hinblick auf die Übertragungspriorität. Gleichzeitig ermöglicht es HTTP/2, die Abhängigkeit eines Streams von einem anderen festzulegen.

Die Gewichtung ist als ganze Zahl von 1 bis 256 definiert. Je höher die Zahl, desto höher ist die Priorität für einen Stream.

Die Abhängigkeit eines Streams von einem anderen wird durch eine spezielle Kennung angezeigt, die auf einen anderen, „übergeordneten“ Stream verweist.

Wenn zum Beispiel Stream X von Stream Y abhängt, bedeutet dies, dass Y der übergeordnete Stream ist und zuerst verarbeitet werden sollte, bevor Stream X verarbeitet wird.

Wenn Streams unabhängig sind, aber unterschiedliche Gewichtung haben, werden sie proportional zu ihren Gewichtungen mit unterschiedlichen Ressourcenmengen behandelt.

Angenommen, Stream X und Stream Y sind unabhängig voneinander, aber X hat den Wert 10, während Y den Wert 15 hat. Berechnen wir nun, wie viel Prozent der Ressourcen jeweils zugewiesen werden sollen:

- X + Y = 10 + 15 = 25

- Für X zugewiesene Ressourcen = 10 / 25 = 40%

- Für Y zugewiesene Ressourcen = 15 / 25 = 60%

So werden dem Verarbeitungsablauf X 40% der Ressourcen zugewiesen, während dem Verarbeitungsablauf Y 60% zugewiesen werden.

Schauen wir uns die Funktionsweise anhand eines genaueren Beispiels an.

Was diese Regelung bedeutet:

- Stream D sollte zuerst verarbeitet werden.

- Die Streams E und C sollten nach D verarbeitet werden. Jedem dieser Bereiche sollten 50% der Ressourcen zugewiesen werden.

- Die Streams A und B werden nach C bearbeitet. A erhält 75% der ressourcen, B 25%.

Welche Möglichkeiten bietet die Prioritätensetzung?

- Sie können festlegen, welche Inhalte zuerst geladen werden sollen.

- Die erste Priorität kann den für die Nutzer wichtigsten Elementen der Website eingeräumt werden.

- Ihre Nutzer haben alle Elemente, die sie für die Interaktion mit Ihrer Website benötigen, bevor diese vollständig geladen ist.

- Dies vermittelt den Eindruck eines schnelleren Ladens und verbessert das Kundenerlebnis.

Wie HTTP/2 Websites in der Praxis schneller macht

Es ist schon eine Weile her, dass HTTP/2 veröffentlicht wurde, und es wurde viele Male getestet und mit HTTP/1.1 verglichen. Verschiedene Tests zeigen unterschiedliche Ergebnisse, aber die meisten bestätigen, dass diese neue Version ihren Vorgänger in der Leistung übertrifft.

Der CCS-Tricks-Test hat zum Beispiel gezeigt, dass eine Website mit HTTP/2 fast doppelt so schnell geladen wird wie eine Ressource mit HTTP/1.1.

Für die Tests simulierte das Unternehmen eine echte einseitige Website auf WordPress. Sie verwendeten das Tool GTMetrix, um die Ladegeschwindigkeit zu messen.

Das Ergebnis war, dass die Seite mit HTTP/1.1 in 1,9 Sekunden geladen wurde.

Und bei HTTP/2 mit denselben Bedingungen betrug die Ladezeit 1 Sekunde.

Wie Sie sehen können, ist gleichzeitig die Anzahl der Anfragen mit HTTP/2 zurückgegangen.

Die Tests von SolarWinds zeigen weniger beeindruckende Ergebnisse. Ihre Tests zeigen, dass die Leistung von HTTP/2 nur 13% besser ist als die seines Vorgängers.

Ähnlich wie bei der vorherigen Studie hat das Unternehmen die Geschwindigkeit einer WordPress-Website gemessen. Für die Messungen wurde Pingdom verwendet. Die Geschwindigkeit wurde 4 Mal alle 30 Minuten überprüft. Aus den Ergebnissen errechneten sie einen Durchschnittswert. Und das ist es, was sie bekommen haben.

Eine Website mit HTTP/1.1 brauchte 534 ms zum Laden.

Dieselbe Website benötigte bei HTTP/2 464 ms zum Laden.

Wie auch immer, HTTP/2 ist derzeit die am meisten optimierte und schnellste Version des wichtigsten Datenübertragungsprotokolls im Internet.

Ziehen wir Bilanz

- HTTP/2 ist die zweite Hauptversion von HTTP, dem Netzwerkprotokoll der Anwendungsschicht, das definiert, wie Inhalte über das Internet übertragen werden.

- HTTP/2 wurde 2015 veröffentlicht und ersetzt HTTP/1.1. Der Hauptzweck der neuen Version war die Beschleunigung der Übertragung von Inhalten.

- Die wichtigste Funktion von HTTP/2, die eine Erhöhung der Übertragungsgeschwindigkeit ermöglichte, war das Stream-Multiplexing. Es ermöglicht Ihnen, eine Verbindung für jede Art von Daten zu erstellen und Informationen parallel zu senden.

- Darüber hinaus werden mit HTTP/2 Inhalte aufgrund von Kopfzeilen-Komprimierung, Stream-Priorisierung und Server-Push schneller übertragen. Außerdem ist es im Gegensatz zu HTTP/1.1 ein binäres Protokoll, was es schneller macht.

- Tests haben gezeigt, dass die Verwendung von HTTP/2 im Vergleich zu HTTP/1.1 einen deutlichen Geschwindigkeitsvorteil beim Herunterladen von Websites bringt.

Das CDN von Gcore unterstützt das HTTP/2-Protokoll. Unser Netzwerk kann Inhalte über HTTP/2 liefern, auch wenn Ihre Server dies nicht unterstützen.

CDN-Merkmale der Gcore:

- Schnell. Die durchschnittliche Reaktionszeit beträgt weltweit weniger als 30 ms.

- Leistungsstark. Gesamtnetzkapazität — mehr als 75 Tbit/s.

- Global. Mehr als 90 Präsenzpunkte auf 5 Kontinenten.

- Kostengünstig. Günstige Tarife und Pauschalpreise weltweit. Es gibt einen kostenlosen Tarif für kleine Projekte.

Inhaltsverzeichnis

- Entwicklungsgeschichte von HTTP/2

- Probleme und Einschränkungen von HTTP/1.1

- Die Leistungsfähigkeit von HTTP/2: wie es Websites beschleunigt und die Datenübertragung verbessert

- Wie HTTP/2 Websites in der Praxis schneller macht

- Ziehen wir Bilanz

Testen Sie das Gcore Netzwerk

Jetzt kostenlos testenÄhnliche Artikel

Was versteht man unter Edge Computing?

Edge Computing bezieht sich auf eine Vielzahl von Technologien, die die Latenzzeit von Cloud-Diensten verringern können. Die geografische Entfernung zwischen dem Endnutzer und dem Server ist der wichtigste Faktor für die Latenzzeit. Alle Edge-Computing-Technologien gehen dieses Problem an, indem sie die Rechenressourcen näher an den Benutzer bringen, wobei sich die einzelnen Edge-Computing-Technologien in den Maßnahmen unterscheiden, die sie zu diesem Zweck ergreifen. Lesen Sie weiter, um mehr über die Unterschiede zwischen Edge-Computing-Technologien, ihre Vorteile und Anwendungen sowie ihr zukünftiges Potenzial zu erfahren.Das Ziel von Edge ComputingDas Ziel von Edge Computing ist die Bereitstellung von Diensten mit niedriger Latenz. Es verfolgt einen dezentralen Ansatz, bei dem Rechenknoten in der Nähe der Nutzer platziert werden, z. B. in kleineren Rechenzentren, Mobilfunkmasten oder eingebetteten Servern.Edge Computing ist eine Ergänzung zum zentralisierten Modell des traditionellen Cloud Computing, bei dem sich die Server in großen, zentralen Rechenzentren befinden. Während sich die Cloud auf die Maximierung der reinen Rechenleistung konzentriert, geht es bei Edge um die Minimierung der Latenz.Wie funktioniert Edge Computing?Edge Computing funktioniert durch das Hinzufügen von Servern an strategischen Standorten in der Nähe der Endbenutzer. Der wichtigste kontrollierbare Faktor, der sich auf die Latenz auswirkt, ist die Entfernung zwischen dem Client und dem Server. Daher ist die Platzierung von Servern in größerer geografischer Nähe zum Client die einzige Möglichkeit, die Latenz sinnvoll zu verringern.Die spezifische Methode zur Implementierung von Edge Computing hängt vom Anwendungsfall und der Schicht ab. Werfen wir einen genaueren Blick darauf, um mehr über die Nuancen des Edge Computing zu erfahren.Die Edge-Computing-SchichtenLassen Sie uns die verschiedenen Schichten des Edge Computing, ihre spezifischen Kontexte, Standorte und erreichbaren Latenzbereiche untersuchen.Traditionelle CloudZunächst müssen wir uns das traditionelle Cloud-Modell ansehen, um eine Grundlage zu schaffen. Diese Schicht eignet sich für daten- und rechenintensive Workloads, Backups und Disaster Recovery. Das traditionelle Cloud-Modell ermöglicht die minuten- oder sogar sekundengenaue Anmietung umfangreicher physischer und virtueller Hardwareressourcen, die hohe Arbeitslasten bewältigen und redundante Speicherlösungen bereitstellen, die die meisten Unternehmen nicht unabhängig verwalten können.Cloud-Anbieter beherbergen Computing-Ressourcen in großen Rechenzentren. Die Latenzzeit kann für Nutzer in der Nähe des Rechenzentrums nur einige Millisekunden betragen, für Nutzer am anderen Ende der Welt kann sie jedoch eine Sekunde überschreiten.Metro EdgeDie Metro-Edge-Schicht dient in der Regel der Inhaltsbereitstellung, der regionalen Einhaltung von Vorschriften und Smart-City-Anwendungen. Hier befinden sich die Rechenressourcen im selben Ballungsraum wie die Nutzer, wodurch Latenzzeiten im einstelligen bis unteren zweistelligen Millisekundenbereich erreicht werden.Metro Edge bietet oft die Sicherheit, dass die lokalen Gesetze zur Datensouveränität eingehalten werden, und sorgt für geringere Latenzzeiten. So bietet ein Cloud-Service mit Sitz in Südamerika möglicherweise nicht den DSGVO-Schutz, der in Europa gesetzlich vorgeschrieben ist. Ein Metro-Edge-Anbieter mit Sitz in Paris kann sowohl die DSGVO-Konformität für lokale Clients gewährleisten als auch ihre Latenz erheblich senken.Far EdgeDer Far Edge ist entscheidend für IoT, autonome Fahrzeuge und Telekommunikation, wo selbst zweistellige Millisekunden-Latenzzeiten zu hoch sind. Auf dieser Schicht werden die Rechenressourcen am Rande des Netzwerks eingesetzt, z. B. in Mobilfunkmasten, was Latenzen von weniger als einer Millisekunde bis hin zum einstelligen Millisekundenbereich ermöglicht.On-Premise EdgeIn Bereichen wie der Fertigung, dem Gesundheitswesen und dem Einzelhandel, in denen Latenzen im Mikrosekundenbereich erforderlich sind, ist On-Premise Edge ideal. So ermöglichen Hochgeschwindigkeitskameras, die Hunderte oder sogar Tausende von Objekten pro Sekunde inspizieren können, die Qualitätssicherung in der Fertigung, ohne die Produktion zu verlangsamen.Wie der Name schon sagt, befinden sich die Rechenressourcen auf dieser Schicht vor Ort, nur wenige Meter von den Nutzern entfernt, was durchweg Latenzen im Mikrosekundenbereich ermöglicht.Anwendungsfälle für Edge Computing in der BrancheUm mehr darüber zu erfahren, wie Edge Computing je nach Kontext unterschiedlich funktioniert, sollten wir uns einige Anwendungsfälle ansehen. Viele verschiedene Branchen nutzen bereits Edge Computing, um ihre Prozesse zu verbessern.EinzelhandelIntelligente Regale melden, welche Produkte sie enthalten und wie viele Artikel noch übrig sind. Dies verwandelt die zeitaufwändige manuelle Inventur, die einige Male im Jahr stattfindet, in einen kontinuierlichen, automatisierten Prozess, der in Echtzeit Einblicke in den Bestand eines Geschäfts bietet.Edge Computing erleichtert dies, indem es die Verarbeitung von Daten in Echtzeit am Ort der Erfassung, z. B. am intelligenten Regal, ermöglicht, wodurch Latenzzeiten vermieden werden und sofortige Aktualisierungen der Lagerbestände möglich sind. Der Vorteil für den Einzelhändler besteht darin, dass er seine Bestandsverwaltung optimieren, Leerstände reduzieren und die Kundenzufriedenheit verbessern kann, indem er sicherstellt, dass die Produkte immer verfügbar sind, wenn sie benötigt werden.Generative KIIm Bereich der generativen KI können KI-Modelle dank Edge Computing mit niedriger Latenz schneller reagieren und den Datenschutz der Eingaben wahren. Edgegesteuerte Chatbots können zum Beispiel Sprache erkennen und schnell Antworten generieren, da sie nicht alle Eingaben an entfernte Datenzentren senden müssen.Intelligente StädteGemeinden erledigen zahlreiche verteilte Aufgaben. Die Bereiche Verkehr und Abfallwirtschaft sind beispielsweise über die ganze Stadt verstreut.Edge Computing ermöglicht es Geräten wie Ampeln, ihre Zeitsteuerung für einen optimierten Verkehrsfluss zu aktualisieren, indem sie die Daten vor Ort verarbeiten. Das bedeutet, dass die Ampelsensoren in Echtzeit auf Änderungen im Verkehrsverhalten reagieren können, ohne dass die Daten zur Verarbeitung an einen zentralen Server zurückgesendet werden müssen, damit der Verkehr reibungslos fließt. Auch in der Abfallwirtschaft kann Edge Computing mit Sensoren ausgestattete Mülltonnen nutzen, um deren aktuellen Füllstand mitzuteilen. Dadurch können Gemeinden die Routen und Zeitpläne für die Müllabfuhr an den unmittelbaren Bedarf anpassen, was die Effizienz erhöht und unnötige Kosten reduziert.AutomobilindustrieSelbstfahrende Autos haben zwar viel Aufmerksamkeit erregt, aber sie sind nicht die einzige IT-Anwendung in modernen Autos. Mit On-Premise Edge Computing, bei dem das Fahrzeug selbst der „Ort“ ist, können Autos Wartungsarbeiten vorwegnehmen und potenzielle Probleme erkennen, bevor sie eskalieren, ohne dass eine ständige Online-Verbindung erforderlich ist.GesundheitswesenAnwendungen im Gesundheitswesen, wie z. B. die Bildanalyse zur Erkennung von Hautkrebs und die Echtzeit-Patientenüberwachung in Krankenhäusern, profitieren enorm vom Datenschutz, den Edge Computing bietet, und erhöhen die Sicherheit der Patientendaten. Edge Computing bietet Datenschutz, indem es Daten lokal auf dem Gerät selbst verarbeitet. Dadurch wird die Gefährdung sensibler Daten durch potenzielle Cyberbedrohungen während der Übertragung erheblich reduziert. Edge Computing trägt auch dazu bei, die Einhaltung lokaler Datenschutzbestimmungen zu gewährleisten, da die Daten innerhalb der geografischen Grenzen bleiben können, in denen sie erzeugt wurden. Dies ist besonders wichtig im Gesundheitswesen, wo Patientendaten hochsensibel sind und strengen Datenschutzgesetzen unterliegen, wie z. B. HIPAA in den USA.FinanzwesenBeim Hochfrequenzhandel dreht sich alles um niedrige Latenzzeiten. Eine Order nur ein paar Millisekunden früher zu platzieren, kann den Unterschied zwischen Gewinn und Verlust ausmachen. Edge Computing verringert die Entfernung zwischen Rechenressourcen und Finanzbörsen und reduziert so die Latenzzeit.Die biometrische Authentifizierung an Geldautomaten ist ein weiterer interessanter Anwendungsfall von Edge im Finanzwesen, bei dem die von Edge gestützte Gesichtserkennung Kunden schnell identifizieren kann und Betrüger daran hindert, gestohlene Kreditkarten zu verwenden.Die Vorteile von Edge ComputingDie Vorteile von Edge Computing sind niedrige Latenzzeiten, Einsparungen bei der Bandbreite und verbesserter Datenschutz.Niedrige LatenzzeitDer Hauptvorteil von Edge Computing ist die deutlich geringere Latenzzeit. Latenzzeiten im einstelligen Millisekunden- oder sogar Mikrosekundenbereich ermöglichen Anwendungsfälle, die mit herkömmlichen Cloud-Implementierungen nicht möglich sind. Ein selbstfahrendes Auto kann zum Beispiel nicht an jeder Kreuzung sekundenlang warten, und die Hochfrequenzhandelsmärkte warten nicht auf Ihre nächste Order. Entweder sie werden schnell ausgeführt oder gar nicht!Einsparungen bei der BandbreiteEdge Computing spart Bandbreite, indem es die Filterung von Daten ermöglicht, bevor diese an die Hauptserver in einer herkömmlichen Cloud gesendet werden, oder die Komprimierung von Medien auf Abruf, bevor diese an einen Client mit geringer Hardwareausstattung oder einer langsamen Internetverbindung gesendet werden. Durch diese frühzeitige Verarbeitung wird die über das Internet gesendete Datenmenge reduziert, wodurch die nachgelagerten Netzwerke entlastet und die damit verbundenen Kosten gesenkt werden können.Verbesserter DatenschutzEs ist möglich, datenschutzoptimiertes Edge Computing auf der lokalen Edge-Schicht zu nutzen, um die Exposition gegenüber öffentlichen Netzwerken zu reduzieren; wie wir im obigen Beispiel aus dem Gesundheitswesen untersucht haben. Der Datenschutz ist jedoch keine Standardeigenschaft von Edge-Computing-Installationen. Der Schutz sensibler Daten zur Einhaltung des regionalen Datenschutzes erfordert ausdrückliche Vorsichtsmaßnahmen, insbesondere wenn Sie mit privaten Daten wie Gesundheitsdaten oder Finanzdaten arbeiten.Warum ist Edge Computing wichtig?Edge Computing ist die Antwort auf eine Reihe aktueller Anforderungen im Zusammenhang mit der ständig wachsenden Zahl vernetzter Geräte, den Einschränkungen herkömmlicher zentraler Server in einer global vernetzten Umgebung und den aktuellen Anforderungen an Latenzzeiten und Datenschutz.Zunahme der Anzahl von GerätenDie Anzahl der mit dem Internet verbundenen Geräte wächst schneller als die Rechenleistung der zentralen Server. Um diesen Trend zu bewältigen, hat Cloud Computing die Skalierung von einem vertikalen Ansatz (Beschleunigung von Servern zur Verarbeitung von mehr Daten) zu einem horizontalen (Verteilung von Arbeitslasten auf mehrere Server) übernommen. Edge Computing setzt diese Verteilung der Arbeitslast fort und bietet eine Leistung mit geringer Latenz, selbst wenn die Anzahl der Geräte exponentiell ansteigt.Einschränkungen der traditionellen zentralen ServerWenn es um die Datenverarbeitung geht, kann der herkömmliche Einsatz von zentralen Hochleistungsservern erhebliche Herausforderungen mit sich bringen. Diese leistungsstarken Server sind nicht nur teuer in der Installation und Wartung, sondern auch logistisch kompliziert in der Bereitstellung an allen erforderlichen Standorten. Da Edge Computing die Datenverarbeitung dezentralisiert, muss jeder Server nur einen lokal begrenzten Satz von Daten verwalten, was die Gesamtlast reduziert und den Einsatz kleinerer, weniger anspruchsvoller und billigerer Server ermöglicht. Es ist daher möglich, Server in einem viel größeren geografischen Bereich zu positionieren. Auf diese Weise löst Edge Computing das teure Problem der Serverbereitstellung und -wartung und macht die Datenverarbeitung effizienter und zugänglicher.Das herkömmliche Cloud Computing ist nicht verschwunden. Hochleistungsserver sind für viele Anwendungsfälle nach wie vor unverzichtbar, aber das Edge Computing entlastet Sie und macht Ressourcen für andere Aufgaben frei.Heutige Anforderungen an Latenzzeiten und DatenschutzNicht zuletzt stellt die moderne Technologie neue Anforderungen an die Latenzzeit und den Datenschutz, die nicht durch eine bloße Erhöhung der Rechenleistung in größeren Rechenzentren erfüllt werden können. Autonome Autos benötigen Reaktionszeiten von weniger als 20 Millisekunden, und Krankenhäuser müssen den Schutz von Patientendaten gewährleisten, die bei der Übertragung über das Internet gefährdet sind. Edge Computing ist in der Lage, diese Anforderungen zu erfüllen, während traditionelle Cloud-Modelle dies einfach nicht durchgängig können.Die Zukunft von Edge ComputingEdge Computing bietet neue Möglichkeiten für die Automatisierung von Aufgaben in verschiedenen Branchen. Der Markt für Edge Computing wird im nächsten Jahrzehnt auf einen Wert von über 157 Milliarden Dollar anwachsen, mit einem erwarteten Wachstum von 80 % im Segment der Großunternehmen. Wir können davon ausgehen, dass es viele neue Edge-Computing-Anwendungen geben wird und dass Unternehmen ihre Arbeitslasten an die Edge verlagern werden, um von den Vorteilen zu profitieren.Verbesserungen bei der Größe und Effizienz der Geräte werden es dem Edge Computing ermöglichen, neue Arbeitslasten zu bewältigen, die heute noch nicht möglich sind, und gleichzeitig bestehende Arbeitslasten zwischen verschiedenen Edge-Computing-Schichten zu verschieben, was noch schnellere Reaktionszeiten ermöglicht.FazitEdge Computing ist eine Erweiterung des traditionellen Cloud Computing. Es sorgt für niedrige Latenzzeiten, indem es Rechenressourcen näher an die Nutzer bringt, die sie benötigen. Viele moderne Lösungen, wie selbstfahrende Autos, Echtzeit-Verkehrsmanagement oder Hochfrequenzhandel, erfordern Edge Computing und wären mit der traditionellen Cloud allein nicht möglich. Edge Computing ist jedoch nicht der evolutionäre Nachfolger des Cloud Computing. Auch wenn es Latenz und Datenschutz weitestgehend verbessert, sind Arbeitslasten, die rohe Rechenleistung erfordern, in einer traditionellen Cloud immer noch gut aufgehoben. Edge Computing ist eine strategische Ergänzung, die die Lücken in der Latenzzeit von Cloud-Computing-Implementierungen schließen und zentrale Server von Lasten entlasten kann, die besser auf verteilte Weise gehandhabt werden.Das Edge-Netzwerk von Gcore umfasst ein leistungsfähiges CDN, das eine durchschnittliche globale Latenz von nur 30 ms liefert. Mit mehr als 150 Präsenzpunkten, die sich strategisch in mehr als 75 Ländern auf sechs Kontinenten befinden, kommen Ihre Endbenutzer in den Genuss der Vorteile von Edge Computing, egal wo auf der Welt sie sich befinden. Anfang 2024 bringen wir außerdem AI Inference as a Service auf den Markt, einen Edge-KI-Dienst. Wir halten Sie auf dem Laufenden.Kostenloses Edge Network CDN erhalten

Was bedeutet die Fehlermeldung „403 Forbidden“? | Maßnahmen zur Behebung

Die Fehlermeldung „403 Forbidden“ auf einer Website bedeutet, dass der Inhalt, auf den ein Benutzer zuzugreifen versucht, blockiert wird. Dieses frustrierende Hindernis hat seinen Ursprung oft auf der Seite des Website-Besuchers, aber die Ursachen sind identifizierbar und der Fehler kann behoben werden. Dieser Artikel bietet praktische Einblicke und schrittweise Lösungen für Website-Besitzer und Systemadministratoren, um den Fehler „403 Forbidden“ zu beheben.Was ist ein 403-Forbidden-Fehler?Ein 403-Forbidden-Fehler ist ein HTTP (HyperText Transfer Protocol)-Statuscode, der den Zugriff auf die Seite blockiert, die ein Benutzer anzuzeigen versucht. Dieser Fehler kann Besucher abschrecken, den Datenverkehr verringern und Sie potenzielle Kunden kosten.HTTP ist ein Regelwerk, das vorgibt, wie Webseiten von einem Ort zum anderen gesendet werden. Wenn Sie versuchen, eine Website aufzurufen, sendet Ihr Webbrowser eine Anfrage an einen Server, der diese HTTP-Regeln verwendet. Der Server antwortet daraufhin, ebenfalls gemäß den HTTP-Richtlinien.Ein HTTP-Statuscode ist eine kurze Nachricht des Servers, die dem Browser des Benutzers mitteilt, wie die Anfrage bearbeitet wurde, und die Informationen über eventuelle Einschränkungen oder Fehler enthält. Ein 403-Code bedeutet konkret, dass der Server Ihre Anfrage zwar verstanden hat, Ihnen aber aufgrund von Berechtigungsproblemen keinen Zugriff auf die Webseite gewähren kann, d. h. dass Sie nicht über die erforderlichen Berechtigungen für den Zugriff auf diese Seite verfügen. So könnte beispielsweise Besuchern aus einem bestimmten Land der Zugriff auf die Seite vom Eigentümer der Website verboten werden, oder ein Nutzer könnte als Kunde angemeldet sein, aber versuchen, auf eine Seite für Mitarbeiter zuzugreifen.Wie sieht der Fehler 403 aus?Das spezifische visuelle Erscheinungsbild eines 403-Forbidden-Fehlers ist anpassbar und kann daher je nach den Entscheidungen des Website-Designers variieren. In der Regel wird jedoch eine dieser Textvarianten auf der Seite angegeben:Fehler 403 – Forbidden403 ForbiddenHTTP 403HTTP-Fehler 403 – ForbiddenHTTP-Fehler 403.14 – ForbiddenForbidden – Sie haben keine Zugriffsberechtigung für diesen ServerForbidden: Sie haben keine Zugriffsberechtigung für [Verzeichnis oder Inhalt] auf diesem ServerHier sind einige Versionen des 403-Forbidden-Fehlers, wie sie in einem Browser erscheinen können:Standard-Fehlermeldung 403 Forbidden in ChromeGoogles 403-Forbidden-FehlermeldungEine kreative, frei zugängliche 403-FehlermeldungEine kreative 403-Forbidden-FehlermeldungObwohl der Wortlaut und das Aussehen des Fehlers von Website zu Website unterschiedlich sein können, sind die Kernaussage und die Auswirkungen auf den Website-Traffic in allen Fällen von Fehler 403 gleich: Der Server lässt Sie oder andere Besucher nicht auf die Seite oder Website zugreifen, die Sie zu erreichen versuchen.Auswirkungen eines 403-FehlersEine 403-Fehlermeldung auf Ihrer Website kann unmittelbare Auswirkungen auf die Benutzerfreundlichkeit, das Suchmaschinen-Ranking und die Sicherheit der Website haben.Benutzerfreundlichkeit und AbsprungrateEin 403-Fehler unterbricht die User Journey des Benutzers auf Ihrer Website und kann sich negativ auf seine Meinung über die Vertrauenswürdigkeit Ihrer Website auswirken. Wenn Benutzer auf diesen Fehler stoßen, sind sie möglicherweise frustriert und/oder verwirrt und fragen sich, warum sie nicht auf die gesuchten Informationen zugreifen können. Aufgrund dieser negativen Erfahrung ist es wahrscheinlicher, dass sie Ihre Website sofort wieder verlassen, was wiederum zu einem Anstieg der Absprungrate führt. Eine hohe Absprungrate deutet darauf hin, dass die Besucher Ihre Website verlassen, ohne sich weiter damit zu beschäftigen, was für Suchmaschinen, die die Qualität der Website bewerten, ein schlechtes Zeichen sein und sich negativ auf Ihr SEO-Ranking auswirken kann.Nehmen wir das Beispiel einer Bildungsplattform. Wenn Studierende beim Zugriff auf Kursmaterialien auf die Fehlermeldung 403 Forbidden stoßen, verpassen sie möglicherweise wichtige Lerninhalte, da der Lernfluss unterbrochen wird. Diese negative Erfahrung könnte dazu führen, dass sie nach alternativen Bildungsressourcen suchen, was ihr Engagement und ihre Loyalität gegenüber Ihrer Plattform verringert. Diese Unterbrechungen beeinträchtigen nicht nur das individuelle Nutzererlebnis, sondern wirken sich auch auf wichtige Leistungskennzahlen der Plattform aus, z. B. auf die Anzahl der aktiven Nutzer und die Gesamtzufriedenheit der Nutzer.SEO und SuchmaschinenindizierungEin 403-Fehler kann sich in mehrfacher Hinsicht negativ auf die Suchmaschinenoptimierung (SEO) Ihrer Website auswirken:Wenn Suchmaschinen-Bots, wie die von Google, beim Crawlen Ihrer Website auf einen 403-Forbidden-Fehler stoßen, können sie die betroffenen Seiten nicht indizieren. Das bedeutet, dass diese Seiten nicht in den Suchergebnissen erscheinen und somit für Ihre Zielgruppe unsichtbar werden.Wenn eine Seite, die zuvor gut platziert war, ständig 403-Fehler aufweist, kann sie sogar deindiziert werden und ganz aus den Suchergebnissen verschwinden.Wenn Ihre Website häufig 403-Fehler anzeigt, kann sich dies negativ auf ihre E-E-A-T-Expertise, Erfahrung, Autorität und Vertrauenswürdigkeit auswirken. Diese Kriterien werden von Google verwendet, um die Qualität einer Website zu bewerten, und andere Suchmaschinen suchen nach ähnlichen Indikatoren.Stellen Sie sich eine E-Commerce-Website vor, auf der Kunden während des Bestellvorgangs aufgrund von geografischen Beschränkungen eine 403-Fehlermeldung erhalten (mehr dazu in Kürze). Dieses Problem hat zwei Seiten: Der Kaufvorgang des Kunden wird unterbrochen und die Bestellseite kann bestraft werden, indem sie nicht indiziert oder sogar deindiziert wird, wenn der Fehler weiterhin besteht. Dies wirkt sich auf die Sichtbarkeit der Seite in den Suchergebnissen aus, was wiederum im Laufe der Zeit zu einem Rückgang der Besucherzahlen und des Umsatzes führen kann.Sicherheitsaspekte und potenzielle SchwachstellenWenn ein 403-Fehler erscheint, bedeutet dies, dass die Website den Zugriff auf eine bestimmte Seite oder Ressource blockiert. Wenn es richtig funktioniert, blockiert dieser Fehler Personen, die keinen Zugang haben sollten, z. B. jemanden, der versucht, auf einen eingeschränkten Finanzdatensatz zuzugreifen. Dies ist für ein Unternehmen von Vorteil, da es dazu beiträgt, sensible Informationen zu schützen.Wenn jedoch auch legitime Benutzer – Mitarbeiter oder Kunden mit ordnungsgemäßer Freigabe – blockiert werden, dann sind die Sicherheitseinstellungen zu restriktiv oder nicht richtig konfiguriert. Dies birgt für das Unternehmen das Risiko von Betriebsstörungen und Kundenunzufriedenheit.In einem Behördenportal könnten Benutzer beim Versuch, auf persönliche Steuerinformationen oder eingeschränkte Behördendokumente zuzugreifen, auf einen 403-Forbidden-Fehler stoßen. Auf den ersten Blick könnte man meinen, dass dies eine gute Sache ist, weil es bedeutet, dass eine solide Sicherheit vorhanden ist. Wenn der Fehler jedoch ungerechtfertigt ist und auf falsche Sicherheitseinstellungen zurückzuführen ist, kann die Ungewissheit im Zusammenhang mit dieser Meldung das Vertrauen der Öffentlichkeit untergraben und Fragen zur Zuverlässigkeit und Wirksamkeit des Portals aufwerfen.403-Forbidden-Fehler – Ursachen und AbhilfeDie oben genannten Auswirkungen machen deutlich, warum es wichtig ist, die Ursache für jeden 403-Forbidden-Fehler zu verstehen und ihn umgehend zu beheben, bevor der Ruf Ihres Unternehmens übermäßig geschädigt wird.Schauen wir uns an, wie spezifische Ursachen für 403-Fehler behoben werden können, jeweils am Beispiel einer E-Learning-Plattform.Unzureichende Datei-/OrdnerberechtigungenUrsache: Stellen Sie sich vor, Sie betreiben eine E-Learning-Plattform und haben gerade eine neue Video-Lektion hochgeladen. Wenn ein zahlender Student beim Versuch, auf die Seite mit dem Video zuzugreifen, die Fehlermeldung „403 Forbidden“ erhält, liegt das Problem möglicherweise an unzureichenden Datei- oder Ordnerberechtigungen. Diese Berechtigungen, die festlegen, wer Dateien lesen, schreiben oder freigeben darf, können an verschiedenen Kontrollpunkten festgelegt werden: auf dem Server, im Dateisystem oder in der Anwendung selbst. Die Blockierung tritt auf, wenn diese Berechtigungen zu restriktiv sind, und kann entweder durch absichtliche Einstellungen von Ihnen, dem Eigentümer der Website, oder durch ein Versehen bei der Konfiguration der richtigen Zugriffsebenen verursacht werden.Abhilfe: Um die Berechtigungen anzupassen und den Fehler zu beheben, haben Sie zwei Möglichkeiten:Verwenden Sie Softwareanwendungen, die als FTP-Clients (File Transfer Protocol) bekannt sind, um die Übertragung von Dateien zwischen Ihrem lokalen Computer und einem Remote-Server – in der Regel Ihrem Webhosting-Server – zu erleichtern. Wenn Sie mit einem FTP-Client eine Verbindung zu Ihrem Server hergestellt haben, navigieren Sie zu der betreffenden Datei oder dem Verzeichnis und klicken Sie mit der rechten Maustaste darauf, um das Menü „Berechtigungen“ oder „Eigenschaften“ aufzurufen. Dort können Sie die Berechtigungen ändern, um das Problem zu beheben, das den 403-Fehler verursacht.Verwendung von webbasierten Systemsteuerungen. In unserem E-Learning-Beispiel würden Sie sich bei Ihrer Systemsteuerung anmelden, zu dem Ordner navigieren, in dem der Kurs gespeichert ist, und die Berechtigungen ändern. Diese Berechtigungen werden mit Hilfe von Zahlencodes oder Kontrollkästchenoptionen festgelegt, die angeben, wer die Dateien im Ordner lesen, schreiben oder ausführen darf. Wenn Sie diese Einstellungen richtig konfigurieren, können Sie die Ressource freischalten und Ihren zahlenden Studenten den Zugang zu dem von ihnen erworbenen Kurs ermöglichen.Falsche ServerkonfigurationUrsache: Wenn ein zahlender Kursteilnehmer nicht auf einen neuen Kurs auf Ihrer E-Learning-Plattform zugreifen kann, ist eine weitere mögliche Ursache eine fehlerhafte Serverkonfiguration. Der Schuldige könnte eine falsche Servereinstellung in Ihrem Apache- oder Nginx-Server sein, die den Zugriff auf den Ordner, in dem der Kurs gespeichert ist, einschränkt. Diese Einstellungen werden oft in den Konfigurationsdateien des Servers definiert, wie z. B. .htaccess für Apache, die den Zugriff auf Ressourcen regeln. Ein Fehler kann auftreten, wenn der Server nicht für die Bearbeitung bestimmter Arten von Anfragen eingerichtet ist oder wenn bestimmte Verzeichnisse in den Servereinstellungen gesperrt sind.Abhilfe: Die Lösung dieses Problems erfordert in der Regel Fachkenntnisse im Bereich der Serververwaltung. Wenn Sie als Website-Besitzer nicht in der Lage sind, dieses Problem im Namen Ihrer Website-Besucher zu lösen, sollten Sie sich an einen Spezialisten wenden. Wenn Sie es selbst tun möchten, müssen Sie die .htaccess-Datei oder eine ähnliche Datei aufrufen und bearbeiten, alle Fehlkonfigurationen korrigieren, die den Kursordner blockieren, und Ihren Server neu starten, um die Änderungen zu übernehmen.Probleme im Zusammenhang mit der AuthentifizierungUrsache: Im Zusammenhang mit Ihrer E-Learning-Plattform könnte ein abgelaufener Authentifizierungs-Token auch verhindern, dass ein zahlender Student auf seinen Kurs zugreift. Diese Token sind wie digitale IDs und können aufgrund von Faktoren wie längerer Inaktivität oder festgelegten Zeitlimits ablaufen.Abhilfe: Die Einstellung des Token-Ablaufs ist ein Problem, das oft von den Website-Nutzern selbst gelöst werden kann. In der Regel müssen Studenten den abgelaufenen Token erneuern, indem sie sich erneut bei ihren Konten anmelden. Auf der Admin-Seite könnten Sie eine Funktion wie eine Schaltfläche „Token erneuern“ auf dem Kurs-Dashboard hinzufügen, damit die Teilnehmer ihre Anmeldedaten leicht selbst zurücksetzen können.Mechanismen zum Schutz von DateienUrsache: Dateischutzmechanismen wie ModSecurity sind Werkzeuge, die als Firewall für Ihren Webserver fungieren und verdächtige Aktivitäten blockieren, um Sicherheitslücken zu verhindern. Obwohl seine Hauptaufgabe darin besteht, Ihre Website zu schützen, kann ModSecurity manchmal zu aggressiv sein und legitime Anfragen – wie die eines Studenten, der auf einen E-Kurs zugreifen möchte – mit bösartigen Anfragen verwechseln.Abhilfe: Die Anpassung der Firewall-Einstellungen erfordert ein differenziertes Verständnis der Web-Sicherheit, sodass diese Aufgabe am besten einem spezialisierten IT-Fachmann überlassen wird. Sie melden sich bei der Systemsteuerung Ihres Servers an und passen die ModSecurity-Regeln an, sodass sie für den Ordner, in dem Ihre Kurse gespeichert sind, weniger restriktiv sind. Sobald die Anpassungen vorgenommen wurden, testet der Spezialist sie, um sicherzustellen, dass der Kurs für Ihre zahlenden Studenten zugänglich ist und die Sicherheit Ihrer Website stabil bleibt.Bewährte Praktiken zur Vermeidung von 403-Forbidden-FehlernUm die Wahrscheinlichkeit eines 403-Forbidden-Fehlers zu minimieren, müssen verschiedene Website-Elemente proaktiv verwaltet werden. Diesmal nehmen wir das Beispiel eines Gesundheitsportals:Feinabstimmung der Zugriffsverwaltung: Die Implementierung von rollenbasierten Zugriffskontrollen verhindert effizient ungerechtfertigte 403-Fehler, indem sichergestellt wird, dass die Benutzer über angemessene, auf ihre Rollen abgestimmte Berechtigungen verfügen. In einem Portal für das Gesundheitswesen werden beispielsweise klar definierten Rollen wie „Krankenschwester“ bestimmte Datenzugriffsrechte zugewiesen, die sowohl für die betriebliche Integrität als auch für die Einhaltung gesetzlicher Vorschriften entscheidend sind. Diese methodische Zuweisung von Berechtigungen stellt sicher, dass jede Benutzerkategorie nahtlos auf die erforderlichen Daten zugreifen kann und das Auftreten von 403-Forbidden-Fehlern aufgrund von Zugriffsbeschränkungen vermieden wird, während gleichzeitig die Daten geschützt und die Einhaltung von Vorschriften wie HIPAA gewährleistet werden.Verzeichnisberechtigungen überprüfen und anpassen: Legen Sie Ihre Verzeichnisberechtigungen nicht einfach fest und „vergessen“ Sie sie dann wieder. Veraltete Berechtigungen können versehentlich sensible Daten blockieren (oder offenlegen). Die regelmäßige Überprüfung und Aktualisierung von Verzeichnisberechtigungen trägt zur Verringerung von Sicherheitsrisiken bei und gewährleistet einen ordnungsgemäßen Zugriff, indem sie mit den von Ihnen definierten Rollen abgeglichen werden. Im Kontext eines Portals für das Gesundheitswesen stellt die Anpassung von Berechtigungen an neues medizinisches Personal oder an geänderte Patientenpflegeprotokolle sicher, dass alle autorisierten Mitarbeiter den erforderlichen Zugriff haben. Auf diese Weise lassen sich Szenarien vermeiden, in denen ein Arzt oder eine Krankenschwester eine 403-Fehlermeldung erhält, weil die Berechtigungen nicht entsprechend ihrer aktuellen Rolle oder ihren Zugriffsanforderungen aktualisiert wurden.Prüfen Sie URL-Muster: Stellen Sie sicher, dass die URL-Struktur Ihrer Website intuitiv ist und den Ressourcen entspricht, um unnötige 403-Fehler zu vermeiden. Das bedeutet, dass die URL-Pfade und Muster die Nutzer zum richtigen Inhalt oder zur richtigen Funktion führen müssen. Überprüfen Sie beispielsweise in einem Portal für das Gesundheitswesen, dass Benutzer, die auf zugelassene Seiten wie ihre persönlichen Daten klicken, nicht versehentlich auf eine Verwaltungsseite gelangen, auf der sie aufgrund von Zugriffsbeschränkungen eine 403-Fehlermeldung erhalten würden.CORS ordnungsgemäß konfigurieren: Wenn Ihre Website mit Ressourcen von anderen Domänen interagiert, richten Sie CORS (Cross-Origin Resource Sharing) ein, um festzulegen, welche Domains auf Ihre Gesundheitsressourcen zugreifen können, ohne dass legitime Anfragen blockiert werden.APIs mit Schlüsseln oder Token absichern: API-Schlüssel oder -Token dienen als eindeutige Identifikatoren, die Interaktionen zwischen Ihrer Website und Diensten von Drittanbietern validieren. Sie tragen dazu bei, zu bestätigen, dass die Anfrage für den Zugriff auf bestimmte Daten oder Funktionen legitim und autorisiert ist, wodurch die Integrität der ausgetauschten Daten und die allgemeine Sicherheit Ihrer Website gewahrt werden. Wenn Ihr Gesundheitsportal also Aktualisierungen von Patientendaten anbietet, indem es Daten von einer externen API eines medizinischen Dienstes abruft, stellt die Verwendung eines API-Schlüssels sicher, dass Ihr Portal nur autorisierte Anfragen an diesen spezifischen medizinischen Dienst stellen kann, wodurch der medizinische Datenaustausch sicher bleibt.Feinabstimmung der Serverkonfigurationsdateien: Die Konfigurationsdateien Ihres Servers, wie z. B. .htaccess für Apache oder nginx.conf für Nginx, steuern, wer welche medizinischen Informationen in Ihrem Portal sehen darf. Sie können spezifische Berechtigungen und Zugriffsregeln festlegen, z. B. dass nur bestimmtes medizinisches Personal auf vertrauliche Patientendaten zugreifen darf.Gründliche Tests durchführen: Testen Sie regelmäßig die Funktionalität und die Sicherheitsmaßnahmen Ihrer Website. Verwenden Sie verschiedene Benutzerrollen, URLs und Datenszenarien, um sicherzustellen, dass alle Elemente ordnungsgemäß funktionieren und dass Ihre Software und Plugins auf dem neuesten Stand sind. Passen Sie sie entsprechend an, um 403-Fehler zu vermeiden.FazitDie Behebung und Vermeidung von 403-Forbidden-Fehlern ist nicht nur für die Funktionalität der Website entscheidend, sondern auch für eine reibungslose User Experience und die Sicherheit Ihrer Website. Implementieren Sie eine zuverlässige Authentifizierung, nehmen Sie eine Feinabstimmung Ihrer Servereinstellungen vor und prüfen Sie, ob unberechtigte Zugriffsversuche vorliegen. Durch diesen proaktiven Ansatz wird Ihre Website zu einem sicheren, zuverlässigen und benutzerfreundlichen Ort für Ihre Zielgruppe.

Was ist BGP? | Alles, was Sie über BGP-Routing wissen müssen

Zwar beginnt jede Anfrage im Internet mit der DNS-Auflösung, doch das ist nur der erste Teil der Reise. Sobald DNS die IP -Adresse eines Servers zurückgibt, leitet das Border Gateway Protocol (BGP) die Anfrage an den entsprechenden Server weiter. BGP navigiert zwischen vernetzten Netzwerken, um Sie mit dem von Ihnen angeforderten Server zu verbinden.Wie bei DNS passiert auch bei BGP eine Menge hinter den Kulissen, einschließlich technischer und geschäftlicher Präferenzen, die die meisten Menschen nicht berücksichtigen. In diesem Leitfaden werden wir uns eingehend mit der Funktionsweise von BGP befassen. Wir werden einige der Auswirkungen von BGP, wie es zwischen autonomen Systemen funktioniert und einige Anwendungsfälle für BGP in der IT-Netzwerkverwaltung besprechen.Wie eine Anfrage das Internet durchläuftWenn Sie eine Website besuchen, muss Ihr Computer die IP-Adresse des Servers herausfinden, der die betreffende Website hostet. DNS-Server liefern diese Informationen zwar, aber der Auflösungsprozess besteht aus mehreren Schritten.Zunächst sendet Ihr Computer die URL der Website an den DNS-Resolver Ihres Internetanbieters. Vorausgesetzt, der DNS-Resolver hat die URL nicht zwischengespeichert, sendet er zunächst eine Anfrage an einen Root-Nameserver.Wenn der Root-Nameserver diese URL nicht zwischengespeichert hat, gibt er die IP-Adresse des Nameservers für die Top-Level-Domain (TLD) zurück. Der TLD-Nameserver gibt dann die IP-Adresse des autorisierenden Nameservers zurück. Dieser gibt die IP-Adresse des Servers zurück, der die Webanwendung hostet, auf die Sie zugreifen wollen.Sobald Ihr Computer die IP -Adresse des Servers kennt, kann er Daten vom Server anfordern, die in der Regel Kopfzeilen, einen Textkörper und andere Metadaten enthalten. Das wirft jedoch die Frage auf, wie Anfragen an eine IP -Adresse den Server finden, den sie suchen.Die Rolle des BGPHier kommt das Border Gateway Protocol ins Spiel.BGP definiert die Regeln dafür, wie Server, die mit dem Internet verbunden sind, einander finden. Ähnlich wie eine App wie Google Maps Ihnen hilft, den Weg zu einer Adresse zu finden, hilft BGP Computern, eine IP-Adresse in einen physischen Server zu übersetzen, mit dem sie sich verbinden und Anfragen stellen können.Es ist wichtig zu wissen, dass das Internet eigentlich kein einzelnes Netzwerk ist, sondern ein Netzwerk von Netzwerken, die Autonome Systeme (AS) genannt werden. Jedes Autonome System kontrolliert die Zustellung von Informationen an jede der ihm zugewiesenen IP-Adressen.Jeder mit dem Internet verbundene Computer ist Teil eines Autonomen Systems, und BGP wird als Protokoll für Routing-Anfragen zwischen Autonomen Systemen und (manchmal) innerhalb jedes Autonomen Systems verwendet. Die meisten Router in Rechenzentren, die mit dem Internet verbunden sind, implementieren BGP, um zu gewährleisten, dass die IP -Adressen ihres Netzwerks jederzeit weltweit erreichbar sind und Aktualisierungen dieser Adressen berücksichtigt werden.BGP bietet eine Reihe von Vorteilen, auf die wir im Laufe dieses Artikels eingehen werden, aber eine seiner grundlegendsten Eigenschaften ist, dass es eine „Schleifenbildung“ verhindert. Indem der gesamte AS-Pfad mit jeder Anfrage gesendet wird, können die empfangenden Router sicherstellen, dass die Anfragen vor der Annahme nicht bereits ihren AS-Pfad enthalten. Dadurch wird verhindert, dass Anfragen in ein endloses Hin und Her zwischen Autonomen Systemen oder Routern geraten, das zu Datenverlusten führen könnte.BGP ist außerdem sehr belastbar. Im Gegensatz zu einigen internen Netzwerkprotokollen verfügt BGP über integrierte Sicherungspfade. Das bedeutet, dass BGP auf die nächstbeste Route zurückgreift, wenn eine Anfrage normalerweise über ein Autonomes System laufen würde, das vorübergehend nicht verfügbar ist.BGP wird zwar hauptsächlich für externe Netzwerkverbindungen verwendet, die Computer über das Internet miteinander verbinden, aber das ist nicht immer der Fall. An dieser Stelle wird die Unterscheidung zwischen internem BGP (IBGP) und externem (EBGP) wichtig.Internes vs. externes BGPExternes BGP bezieht sich auf das Border Gateway Protocol, das zwischen verschiedenen Autonomen Systemen angewendet wird, während internes BGP die Anwendung des Protokolls zwischen Routern innerhalb eines Autonomen Systems ist.Mit anderen Worten: Wenn eine Anfrage an ein AS außerhalb des AS des Anfragenden gestellt werden muss, wird EBGP verwendet. Wenn eine Anfrage an einen anderen Server innerhalb desselben AS gestellt wird, könnte iBGP verwendet werden. Eine Anfrage kann auf ihrem gesamten Weg zu dem durch die IP -Adresse beschriebenen Server Router durchlaufen, die beide Versionen des Protokolls verwenden. Das Autonome System wird jedoch in der Regel nur EBGP auf dem Randknoten verwenden, der es mit anderen Autonomen Systemen verbindet.Einer der großen Unterschiede zwischen IBGP und EBGP ist der Mechanismus zur Vermeidung von Schleifen. Da IBGP für die Verwendung innerhalb desselben Autonomen Systems vorgesehen ist, muss jeder Router im Netzwerk Routing-Informationen mit seinen benachbarten Peers austauschen. Wenn einer der Router ein Update von einem Peer erhält, weiß er, dass er es nicht an andere IBGP-Nachbarn weitergeben darf.Abbilden einer Route mit minimalen Sprüngen (Hops)Jedes AutonomeSystem ist physisch mit mindestens einem anderen Autonomen System an einem Internet Exchange Point (IXP) verbunden. Manchmal muss eine Anfrage jedoch mehrere Autonome Systeme durchlaufen, um die gewünschte IP-Adresse zu erreichen. BGP erleichtert dies, indem es vorschreibt, dass Autonome Systeme sich über den Pfad mit den wenigsten Sprüngen verbinden.Im folgenden Diagramm leitet BGP beispielsweise Anfragen von AS 1 nach AS 5 über AS 3 (die grüne Linie).Wie bereits erwähnt, ist BGP sehr resilient. Das Internet funktioniert unter anderem deshalb so gut, weil BGP auf die nächstbeste Option zurückgreift, wenn eine der Verbindungen über ein Autonomes System ausfällt. Wenn beispielsweise die physische Verbindung zwischen AS 3 und AS 5 unterbrochen würde, würde BGP Anfragen über AS 4 und AS 6 (die rote Linie) leiten.Wie wir später sehen, bringt die Suche nach minimalen Sprüngen einige Probleme mit sich, aber größtenteils trägt dies dazu bei, die geringstmögliche Latenz zwischen Servern überall auf der Welt aufrechtzuerhalten.Unicast vs. AnycastBis jetzt sind wir davon ausgegangen, dass jede IP -Adresse einem einzelnen Server zugewiesen ist. Dies wird als Unicast bezeichnet und ist zwar das häufigste Muster für die IP-Zuweisung, aber nicht die einzige Option. IP -Adressen können auch mehreren Servern an mehreren physischen Standorten zugewiesen werden. Diese Konfiguration wird als Anycast bezeichnet und bietet einige interessante Vorteile.Auf der positiven Seite kann Anycast schnellere Anfragen und Antworten ermöglichen. Da BGP Anfragen an den Server sendet, der die geringste Anzahl von Sprüngen entfernt ist, verringert Anycast die Anzahl der Autonomen Systeme, die eine Anfrage durchlaufen muss, bevor sie ihr Ziel erreicht.Dies macht Anycast nützlich für das Load Balancing. Da Autonome Systeme an irgendeinem Punkt eine physische Verbindung herstellen müssen, ist der Pfad mit den wenigsten Sprüngen in der Regel auch die kürzeste physische Entfernung zwischen Servern.So, if you assign a server in Europe an IP Wenn Sie also einem Server in Europa eine IP-Adresse zuweisen und dann dieselbe IP-Adresse einem Klon dieses Servers in den Vereinigten Staaten zuweisen, werden Anfragen aus Europa höchstwahrscheinlich auf dem europäischen Server landen, während Anfragen aus den USA wahrscheinlich auf dem US-Server landen werden. Anycast bietet zudem Redundanz. Wenn der europäische Server im vorherigen Beispiel ausfällt oder das Netzwerk verlässt, werden die Anfragen stattdessen an den US-Server weitergeleitet.Leider ist die Einrichtung von Anycast komplizierter als die von Unicast, sodass es in der Regel nur für Internetanbieter oder Webhosting-Unternehmen sinnvoll ist. Anycast funktioniert auch besser über IPV6, das nach wie vor nicht von jedem Autonomen System unterstützt wird. Allerdings bieten viele große Webhosting- und DNS-Anbieter, einschließlich Gcore, Anycast als Teil ihrer Dienste an.Mögliche Probleme mit BGPIm Großen und Ganzen ist BGP eine solide Lösung für eine komplizierte technische Herausforderung, aber es ist nicht ohne Einschränkungen und Schwächen. Unternehmen, die Autonome Systeme betreiben, müssen entscheiden, wie sie die Anforderung der geringsten Sprünge in BGP interpretieren. Manchmal stehen ihre Präferenzen auch im Widerspruch zu denen eines Benutzers.Bei der Implementierung von BGP treten Probleme auf, wenn mehrere Pfade für die Weiterleitung von Anfragen über dieselbe Anzahl von Sprüngen verwendet werden könnten. Wenn beispielsweise eine Anfrage für eine IP -Adresse in New York aus Memphis kommt, gibt es möglicherweise zwei Pfade, die einen Sprung erfordern: einen über Chicago und einen über London.Während Chicago die logische Wahl zu sein scheint, da es physisch näher an New York und Memphis liegt, könnte ein Internet Service Provider, der ein Autonomes System in Memphis kontrolliert, es vorziehen, alle Anfragen in seinem Netzwerk zu halten. Wenn dieser die Verbindung von Chicago nach New York nicht selbst besitzt, muss er möglicherweise mehr für die Bandbreite bezahlen, sodass er es vorziehen würde, die Anfragen erst nach London und dann nach New York zu leiten.Das mag zwar für den Internetanbieter von Vorteil sein, da er dadurch Geld spart, aber für die Nutzer bedeutet es möglicherweise eine höhere Latenz. Dies ist ein extremes Beispiel, aber es verdeutlicht, dass BGP nicht unbedingt dem Anfragesteller oder Server dient.So kontrollieren Regierungen in vielen Teilen der Welt Autonome Systeme. Wenn eine Regierung Teile des Internets außerhalb ihres Zuständigkeitsbereichs einschränken will, kann dies zu unbeabsichtigten weitreichenden Ausfällen führen. Im Jahr 2008 schnitt Pakistan den Zugang zu YouTube ab, aber anstatt die Seite nur innerhalb der eigenen Grenzen zu sperren, entfernte es versehentlich die IP -Adressen von YouTube vollständig, was zu einem weltweiten Ausfall von YouTube führte.BGP in der PraxisZwar gibt es diese makroökonomischen Probleme mit BGP, aber es handelt sich dabei um Grenzfälle, über die sich ein Netzwerkadministrator in der Regel keine Gedanken machen muss. Unabhängig davon, ob Sie IBGP zwischen netzinternen Systemen oder EBGP als Verbindung zu anderen Autonomen Systemen verwenden, ist es wichtig zu verstehen, wie Sie das BGP-Protokoll nutzen können.VPN-IP-Announcement. Da BGP über eine integrierte Ausfallsicherung verfügt, ist es von Vorteil, es für das IP-Announcement anstelle des traditionellen statischen IP-Routings zu verwenden. Ohne BGP auf Ihrem Router müssen Sie den Zustand des Servers regelmäßig überprüfen, um sicherzustellen, dass er noch ordnungsgemäß routet. Viele Webhoster und auch Gcore bieten ein BGP-IP-Announcement an, sodass Sie dies möglicherweise nicht selbst konfigurieren müssen.Backdoor-BGP-Routing. Wie bereits erwähnt, folgt BGP der Route mit den wenigsten Sprüngen zwischen den Knoten. Das kann jedoch bedeuten, dass eine Anfrage mehrere Autonome Systeme durchläuft, um ihr Ziel zu erreichen. Diese Anordnung ist möglicherweise nicht sinnvoll, wenn Sie Ihren Netzwerkverkehr innerhalb eines einzigen AS halten möchten. Glücklicherweise kann internes BGP den Netzwerk-Backdoor-Befehl verwenden, um einen bevorzugten Pfad innerhalb des AS festzulegen.Netzwerk-Peering. Eine weitere Möglichkeit, BGP so zu manipulieren, dass netzinterne Verbindungen bevorzugt werden, ist Netzwerk-Peering. Indem Sie zwei Knoten in einem Netzwerk als Peers bezeichnen, können Sie Anfragen zwischen diesen Knoten zulassen, ohne dass sie ins öffentliche Internet gelangen. Sowohl Peering als auch Backdoor-Routing ermöglichen es Ihnen, bei der Bearbeitung interner Anfragen Geld zu sparen und die Netzwerksicherheit zu verbessern.FazitBGP ist ein grundlegender Bestandteil der Funktionsweise des Internets, und seine Ausfallsicherheit trägt zur relativen Stabilität und hohen Verfügbarkeit des heutigen Internets bei. Aus der Sicht der Netzwerkadministration ist es wichtig, dies zu verstehen, denn selbst wenn Sie kein eigenes Autonomes System haben, werden Sie wahrscheinlich mit BGP interagieren, um Verbindungen mit anderen Netzwerken herzustellen oder Routing-Probleme zu beheben.Wenn Sie wissen, wie Sie BGP verwenden, um einen globalen Lastausgleich durch Anycast, IP-Announcement für VPNs und die Beeinflussung von Routing-Präferenzen innerhalb eines AS zu ermöglichen, können Sie den größten Nutzen für Ihr Unternehmen erzielen.Wenn Sie einen DNS-Anbieter mit Anycast oder eine Webhosting-Plattform mit VPN-IP-Announcement über BGP suchen, dann ist Gcore eine hervorragende Wahl. Zusätzlich zu den in diesem Beitrag erwähnten Funktionen bietet Gcore:26 ms durchschnittliche Latenzzeit weltweit und 12 ms in EuropaGeoDNS-Funktionalität mit verschiedenen Arten des Ausgleichs (nach Gewichten, Georegionen, geo lat/long, ASN)DDoS-Schutz und DNS-Failover zur Vermeidung von AusfällenUnterstützung von OctoDNS, Terraform, Certbot und externen DNSWildcard-DNS-UnterstützungErschwingliche Tarife, einschließlich eines kostenlosen TarifsGeschrieben von Karl Hughes

Was ist HTTP/3 und wie unterscheidet es sich von HTTP/2?

Hypertext Transfer Protocol (HTTP) ist das Kernprotokoll des World Wide Web, das als Portal für die Kommunikation zwischen Webbrowsern und Servern dient. Es gibt verschiedene Versionen von HTTP, von denen die neuesten HTTP/2 und HTTP/3 sind. Dieser Artikel bietet eine vergleichende Analyse von HTTP/2 und HTTP/3 und erklärt, warum Sie zu letzterem wechseln sollten.Was ist HTTP/3?HTTP/3 ist ein deutlicher Fortschritt gegenüber HTTP/2. Es wird über QUIC aufgebaut, ein Transportprotokoll, das sich durch Eigenschaften wie verbesserte Leistung, geringere Latenzzeiten, erhöhte Sicherheit und bessere Bewältigung von Netzschwankungen auszeichnet.Die dritte Generation des ProtokollsHTTP/3 ist die neueste Generation von HTTP. In der nachstehenden Tabelle sind die früheren Versionen, das Erscheinungsjahr, die Spezifikationen und die wichtigsten Funktionen aufgeführt.HTTP-VersionVeröffentlichtSpezifikationWesentliche MerkmaleHTTP/0.91991Keine RFC-NummerEinzeiliges Protokoll nur mit GETHTTP/11996RFC 1945Statuscodes, HTTP-Header, POST und HEADHTTP/1.11997RFC 9112Keep-alive-Verbindung, weitere HTTP-FunktionalitätenHTTP/22015RFC 9113TCP (Transmission Control Protocol), eine neue binäre Framing-Schicht, Multiplexing, Header-Kompression (HPACK), Server-seitiger PushHTTP/32022RFC 9114QUIC über UDP (User Datagram Protocol), TLS als Standard, Header-Kompression (QPACK), Verbindungs-IDHTTP/3 löst HTTP/2 ab, da es QUIC anstelle von TCP implementiert. Untersuchen wir also, warum QUIC besser ist als TCP und wie es zur Überlegenheit von HTTP/3 beiträgt.HTTP über QUICQUIC wurde von Google entwickelt und läuft über UDP – ein verbindungsloses, leichtgewichtiges Protokoll. Lassen Sie uns drei Hauptvorteile von QUIC untersuchen:TCP, das von HTTP/2 verwendet wird, überträgt und liefert Datenströme in genau der Reihenfolge, in der der Absender sie erzeugt hat. Dieser Ansatz verhindert zwar Paketverluste, ist aber auch die Hauptursache für das HOL-Blocking-Problem von HTTP/2. QUIC hingegen ist verbindungslos und ermöglicht Multiplexing auf der Transportschicht, wodurch das Head-of-Line-Blocking-Problem von TCP vermieden wird.Da UDP keine Client-Server-Verbindung erfordert, erleichtert es die Datenübertragung über optimale Routen. Dieser Ansatz verfügt jedoch nicht über einen Mechanismus zur erneuten Übertragung von Daten, sodass er in der Regel zu Paketverlusten führt. QUIC löst dieses Problem durch Multiplex-Verbindungen auf höherer Ebene (damit mehrere Datenströme gleichzeitig und unabhängig voneinander übertragen werden können) und verhindert, dass sich Paketverluste in einem Datenstrom auf andere auswirken.QUIC bietet eine Bandbreitenabschätzung sowohl in Server- als auch in Client-Richtung, um festzustellen, wie viele Daten ein Netz innerhalb einer bestimmten Sitzung übertragen kann, sowie Vorwärtsfehlerkorrektur-Funktionen (durch FEC-Pakete), um Fehler in instabilen Netzumgebungen zu vermeiden und die Leistung weiter zu verbessern.Weitere Unterschiede zwischen HTTP/2 und HTTP/3Abgesehen von den Unterschieden im Transportschichtprotokoll (TCP vs. QUIC) gibt es weitere Unterschiede zwischen HTTP/2 und HTTP/3:UnterscheidungsmerkmaleHTTP/2HTTP/3Protokoll der TransportschichtTCPQUIC, das über UDP arbeitetMultiplexing & head-of-line (HOL)Aufgrund von Beschränkungen bei der Abstraktion von Byteströmen kommt es bei gemultiplexten Strömen häufig zu Head-of-Line-Blocking-ProblemenBietet Multiplexing ohne Head-of-Line-Blocking aufgrund von UDP’s Out-of-Order DeliveryFehlerbehandlungWeniger Möglichkeiten zur FehlerbehandlungVerbesserte Möglichkeiten der Fehlerbehandlung durch QUICTLS-VerschlüsselungTLS ist optionalTLS ist in QUIC und standardmäßig in HTTP/3 eingebettetVerbindungsmigrationUnterstützt keine VerbindungsmigrationUnterstützt nahtlose Verbindungsmigration über Verbindungs-IDs (CIDs) (siehe unten)HTTP/2- und HTTP/3-Stack-VergleichAbgesehen von den Unterschieden in ihren Angeboten sind HTTP/2 und HTTP/3 auch architektonisch verschieden.HTTP/2 vs. HTTP/3Die einzelnen Komponenten im Diagramm – und ihre Unterschiede zwischen HTTP/2 und HTTP/3 – werden im Folgenden erläutert.HTTP-SemantikHTTP-Semantiken sind die Ressourcen-Metadaten, die an Anfragen und Antworten angehängt sind. Dazu gehören Header-Felder für Anfragen und Statuscodes für Antworten. Die Semantik von HTTP/3 und HTTP/2 ist in Bezug auf das Datenformat und die Anfrage-/Antworttypen ähnlich. Die Reihenfolge ihrer Anordnung ist jedoch unterschiedlich.HTTP/2 hat eine eigene Anwendungsschicht (HTTPS), eine optionale Sicherheitsschicht (TLS) und eine Transportschicht (TCP), die in dieser Reihenfolge angeordnet sind.Die Schichten in HTTP/3 sind weniger klar voneinander abgegrenzt, wobei HTTPS die Anwendungsschicht ist, HTTPS und QUIC eine eingebaute Sicherheitsschicht bilden und QUIC und UDP die Transportschicht darstellen.Die folgende Abbildung gibt einen Überblick über die Beziehungen zwischen den einzelnen Ebenen.HTTP/2- vs. HTTP/3-SchichtenHeader-KomprimierungHierbei handelt es sich um einen Mechanismus zur Komprimierung der Header (einschließlich IP-, UDP- und TCP-Header) von Datenpaketen vor dem Versand, um die Paketübertragung zu beschleunigen, den Bandbreitenverbrauch zu verringern und den Netzwerk-Overhead zu begrenzen. HTTP/2 verwendet HPACK für die Header- oder Feldkomprimierung, während HTTP/3 QPACK verwendet. Obwohl sowohl HPACK als auch QPACK effizient sind, arbeiten sie unterschiedlich, und während HPACK anfällig für HOL ist, ist QPACK es nicht.Server-Push und PriorisierungBeim Server-Push werden die Ressourcen von den Servern präventiv an die Clients gesendet, um die Latenzzeit zu verringern. Sowohl HTTP/2 als auch HTTP/3 unterstützen Server-Push. In HTTP/3 können die Clients jedoch die Anzahl der zulässigen Push-Nachrichten über die Push-Stream-ID festlegen, um die verschwendete Bandbreite zu verringern.Stream-MultiplexingSowohl HTTP/2 als auch HTTP/3 unterstützen Multiplexing, sodass mehrere Anfragen und Antworten gleichzeitig über eine einzige Verbindung gesendet werden können. TCP, das von HTTP/2 verwendet wird, betrachtet jedoch jede Anfrage (auch gemultiplexte) als einen einzigen Bytestrom. Dieser von TCP verwendete Ansatz ist in der Regel die Ursache für HOL-Probleme beim Multiplex-Streaming in HTTP/2. In HTTP/3 wird dieses Problem durch die Implementierung von UDPs Out-of-Order-Delivery gelöst, bei der jeder Bytestrom unabhängig voneinander über das Netz transportiert wird.TLS-Verschlüsselung (Transport Layer Security)Beide Protokolle bieten TLS-Verschlüsselung. In HTTP/2 ist TLS jedoch optional, und die TLS-Verschlüsselung erfolgt über die gängigen Protokolle TLS 1.2 und TLS 1.3. In HTTP/3 wird die TLS-Verschlüsselung standardmäßig über den QUIC-Schlüsselaustauschmechanismus bereitgestellt, wodurch das Risiko des Abhörens, der Datenmanipulation und anderer Sicherheitsbedrohungen allgemein verringert wird.Sitzungswiederaufnahme/0-RTTBei der Wiederaufnahme einer Sitzung werden die in früheren Übertragungen verwendeten Parameter wiederverwendet, ohne dass ein vollständiger Handshake eingeleitet wird. In HTTP/2 wird die Sitzungswiederaufnahme mit dem TLS-Sitzungsticket-Mechanismus implementiert, bei dem mindestens zwei Runden Handshakes – TCP & TLS – erforderlich sind, bevor die Verbindung wiederhergestellt werden kann. Andererseits nutzt HTTP/3 die 0-RTT-Funktion (zero round trip time resumption) von QUIC, die es den Clients ermöglicht, verschlüsselte Daten im ersten Paket des Handshake zu senden, was eine schnellere Wiederaufnahme früherer Sitzungen ermöglicht.IPv4 / IPv6IP-Adressen werden verwendet, um virtuelle Verbindungen zwischen Geräten und Netzen herzustellen. IPv4 verwendet 32-Bit-Adressen, während IPv6 128-Bit-Adressen verwendet. Sowohl HTTP/2 als auch HTTP/3 bedienen beide IP-Typen.Andere besondere Merkmale von HTTP/3Während der Stack-Vergleich ihrer jeweiligen Architektur wichtige Gründe für die Überlegenheit von HTTP/3 aufzeigt, gibt es noch weitere Merkmale, die HTTP/3 einen Vorteil gegenüber HTTP/2 verschaffen.Weniger Handshakes, schnellere VerbindungHTTP/3 stellt effiziente Verbindungen her und verringert die Latenzzeit, indem es die Anzahl der zum Verbindungsaufbau erforderlichen Handshakes reduziert. Bei HTTP/2 umfasst der Verbindungsaufbau eine Reihe von Handshakes zwischen dem Client und dem Server. Diese Handshakes führen zu zusätzlichen Umläufen und erhöhen die Latenzzeit beim Verbindungsaufbau.Nahtlose Verbindungsmigration mit CIDDie Verbindungs-ID (CID) in HTTP/3 erleichtert die Migration, wenn ein Client das Netz oder das Gerät wechselt. Dank der CID-Funktion können Clients eine stabile Verbindung aufrechterhalten, ohne dass neue Handshakes erforderlich sind. Wenn der Client das Netz oder das Gerät wechselt, werden einfach die mit der Verbindung verbundenen Netzinformationen aktualisiert, wobei die CID beibehalten wird.Dies ist vor allem in Szenarien wie dem Wechsel von WLAN zu Mobilfunk oder umgekehrt von Vorteil. Die nahtlose Migration sorgt für ein reibungsloses Surfen im Internet und verringert die Wahrscheinlichkeit, dass Verbindungen gekapert oder abgefangen werden.Einführung von HTTP/3Mehrere Organisationen haben die Vorteile von HTTP/3 erkannt und setzen es aktiv ein. Was die Browserunterstützung betrifft, so haben Google Chrome, Mozilla Firefox, Opera und Microsoft Edge HTTP/3 implementiert. Safari, der von Apple entwickelte Webbrowser, implementiert das Protokoll derzeit jedoch nicht.Die Bereitschaft globaler Unternehmen und der Mehrheit der Browser, HTTP/3 zu verwenden, ist ein weiterer Beweis für die Überlegenheit von HTTP/3 gegenüber HTTP/2. In dem Maße, in dem die mit der Implementierung verbundenen Herausforderungen überwunden werden, wird die Akzeptanz von HTTP/3 weiter zunehmen und zu einer breiteren Unterstützung durch verschiedene Browser und Plattformen führen.Herausforderungen der HTTP/3-ImplementierungDie Einführung von HTTP/3 kann bestimmte Herausforderungen mit sich bringen, die bei der Umsetzung zu bewältigen sind; einige davon werden im Folgenden beschrieben.Kompatibilität mit bestehender InfrastrukturUm auf HTTP/3 umzusteigen, müssen Sie Ihre bestehende Infrastruktur, einschließlich der Server und Load Balancer, ändern. Selbst nach dem Wechsel kann die Kompatibilität noch eine Herausforderung darstellen, insbesondere wenn Ihr Unternehmen groß ist und/oder über komplexe Netzwerkeinstellungen verfügt.Firewall-KompatibilitätDas QUIC-Transportprotokoll, das von HTTP/3 verwendet wird, verschlüsselt Datenpakete in ihrer Gesamtheit, von der Nutzlast bis zu den Metadaten. Die Verschlüsselung ist zwar vorteilhaft, erschwert aber den Zugriff auf die Datenpakete. Firewalls benötigen jedoch Zugang zu den Datenpaketen; ohne diesen Zugang sind die Kunden Cyberangriffen ausgesetzt.Client-seitige Browser-Unterstützung und Server-ImplementierungObwohl viele Browser HTTP/3 übernommen haben, hat Safari dies nicht getan. Die HTTP/3-Implementierung auf der Serverseite erfordert Fachwissen und möglicherweise müssen Sie sogar Ihre Serverinfrastruktur aktualisieren.Die Kompatibilität mit bestehenden HTTP/2- oder HTTP/1.x-Implementierungen ist eine weitere Herausforderung. Die Kompatibilität ist für die nahtlose Übertragung von Anfragen über die verschiedenen Protokolle hinweg von entscheidender Bedeutung – besonders wichtig während des schrittweisen globalen Übergangs zu HTTP/3. Es ist zwar möglich, aber schwierig, die Umstellung ohne Unterbrechung der bestehenden Dienste und Verbindungen durchzuführen.HTTP/3 für CDNContent-Delivery-Networks (CDNs) speichern Inhalte in einem Zwischenspeicher an mehreren Serverstandorten auf der ganzen Welt. Mit der weiteren Verbreitung von HTTP/3 wird auch der tangentiale Nutzen für CDNs weiter zunehmen, was CDN-Anbieter ermutigt, das Protokoll zu implementieren und damit seine Verbreitung zu fördern. Die HTTP/3-CDN-Romantik kann folgende Vorteile bieten:Native Verschlüsselung: Da HTTP/3 TLS-Verschlüsselung bietet, kann die Einbindung von HTTP/3 in CDNs die native Verschlüsselung erleichtern, statt sich auf die sofort einsatzbereite TLS-Verschlüsselung für Caches zu verlassen. Dadurch wird die Sicherheit von eigenen und externen Netzen erhöht.Verkürzter Verbindungsaufbau: Durch die Verwendung von QUIC minimiert HTTP/3 die Verbindungszeit und bietet nahtloses Multiplexing und schnellere Fehlererkennung. CDNs, die HTTP/3 nutzen, werden von dieser geringeren Latenz stark profitieren und die Gesamtleistung und Zuverlässigkeit der Inhaltsbereitstellung verbessern.Obwohl diese Vorteile verlockend sind, müssen CDN-Anbieter zunächst in die HTTP/3-Unterstützung investieren, indem sie ihre Infrastruktur aktualisieren und ihre Edge-Server neu konfigurieren, um ihren Kunden die Vorteile bieten zu können.FazitAufbauend auf den Stärken von HTTP/2 und der Beseitigung seiner Schwächen bietet HTTP/3 eine verbesserte Leistung, erhöhte Sicherheit, geringere Latenzzeiten und eine bessere Handhabung von Netzwerkbedingungen, was es zu einem vielversprechenden Protokoll für die Zukunft der Webkommunikation macht.Bei Gcore arbeiten wir ständig daran, das Internet besser zu machen. Deshalb entwickeln und investieren wir aktiv in unser globales Edge-Netzwerk (CDN) um HTTP/3 zu unterstützen und für alle verfügbar zu machen. Sobald das System einsatzbereit ist, können Sie eine schnellere und sicherere Verbindung für Ihre Website und Anwendungen nutzen. An dieser Stelle finden Sie immer die aktuellsten Informationen!Erfahren Sie mehr über Gcore CDN

DNS-Einträge erklärt