€0

Adaptive Bitratenkodierung kostenlos

210+Standorte

Lokale und globale Infrastruktur für Streaming, CDN und WebRTC

∞

Beseitigen Sie die Einschränkungen und Probleme Ihrer aktuellen Lösung

Erhalten Sie optimierte Streaming-Leistung mit Leichtigkeit

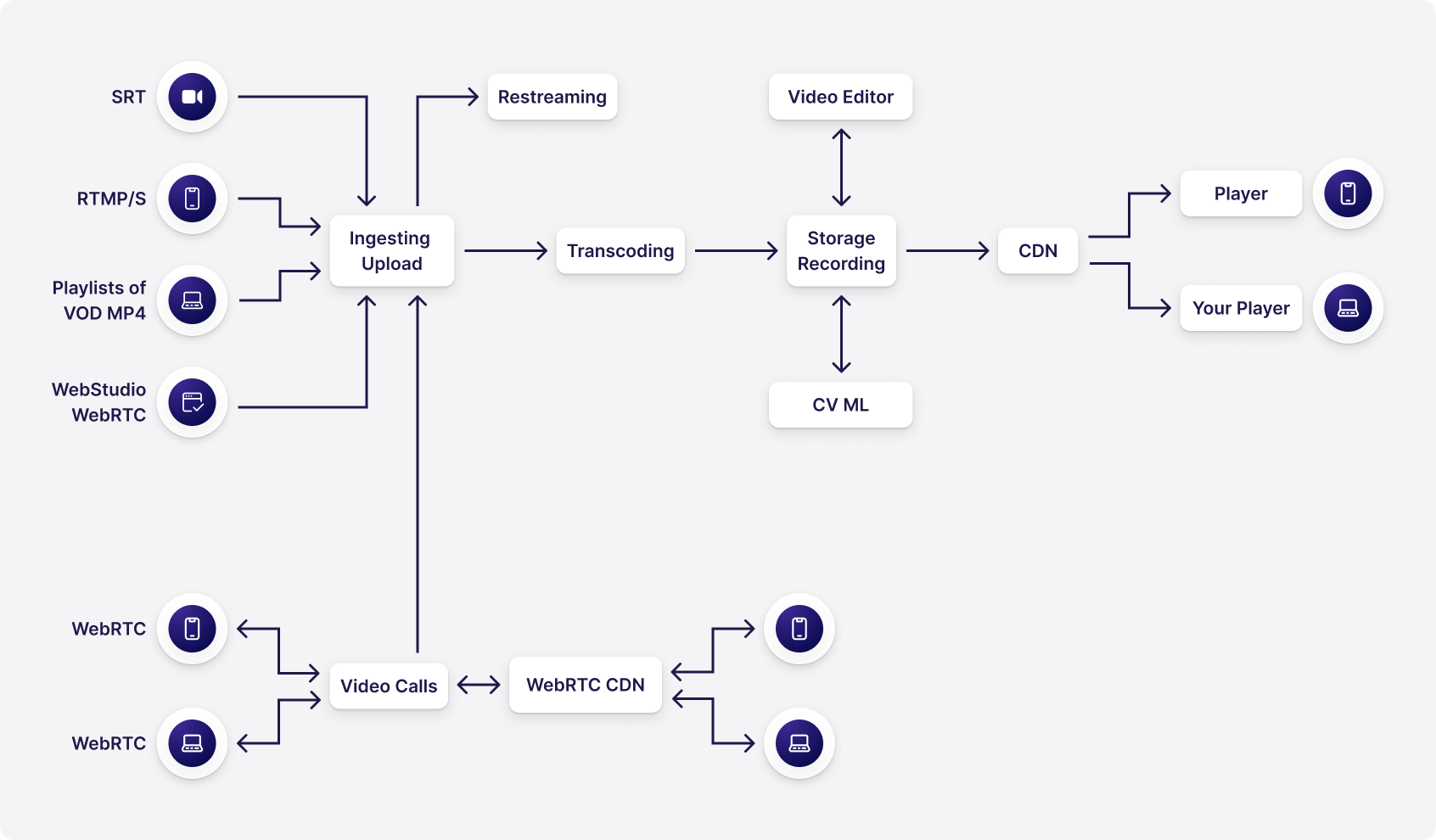

Wir unterstützen alle Aspekte des Streamings auf einer Plattform: Upload, Live-Eingang, Transcodierung, Aufnahme, Speicherung, Videobearbeitung mit Machine Learning, Auslieferung über CDN, Multistream, eingebetteter Player und Wiedergabe.

Scroll horizontally to view the chart

Zufriedene Kunden

Aus verschiedenen Branchen

Funktionen

Bereit, loszulegen?

14-tägige kostenlose Testversion

Geographie von Streaming-Diensten

Punkte für das Hosting von Videos und den Empfang von Live-Streams demnächst verfügbar

CDN-Punkte für die Übertragung von Videos an Endbenutzer (Gesamtkapazität >100 Millionen Zuschauer)

Punkte für das Hosting von Videos und den Empfang von Live-Streams demnächst verfügbar

CDN-Punkte für die Übertragung von Videos an Endbenutzer in Kürze verfügbar

Preisgestaltung

Arbeitsablauf bereit

Video-Infrastruktur, wie Entwickler sie sehen. Verwenden Sie einfach ein einfaches Dashboard oder integrieren Sie Ihre mobile App, Website, Unternehmens-CMS oder andere Software mit einem SDK und einer API.

Brancheninhalte, die Ihnen gefallen könnten

Mehr Informationen in unserem Blog → Die neuen FastEdge-Updates für November

Die neuen FastEdge-Updates für NovemberFür FastEdge, unsere serverlose Edge-Computing-Lösung, veröffentlichen wir diesen Monat Verbesserungen, die Workflows vereinfachen, die Sicherheit erhöhen und das Anwendungsmanagement optimieren. Kunden von FastEdge haben jetzt Zugang zu Secret Storage Support, CLI und Konfigurationsvorlagen. Außerdem haben wir die Steuerung des Gcore-Kundenportals verbessert. Das sind die Neuerungen:Secret Storage SupportDie Verwaltung sensibler Informationen ist eine zentrale Herausforderung für moderne Anwendungen. Mit dem Secret Storage Support haben Sie jetzt Zugriff auf ein robustes System zur Verschlüsselung und Verwaltung von API-Schlüsseln, Anmeldeinformationen, Token und anderen sensiblen Daten in den Umgebungsvariablen Ihrer Anwendung.Das bedeutet für Sie Folgendes:Verbesserte Sicherheit: Schützen Sie vertrauliche Informationen mit den neuesten Verschlüsselungstechniken und verringern Sie so das Risiko von absichtlichen oder versehentlichen Datenlecks.Schlankere Verwaltung: Vereinfachen Sie Ihre Anwendungskonfiguration mit einem einzigen, sicheren Workflow für Umgebungsvariablen.Einhaltung gesetzlicher Vorschriften: Erfüllen Sie die strengen Datenschutz- und Datensicherheitsstandards und schützen Sie Ihre Anwendungen damit vor Verstößen und aufsichtsrechtlichen Konsequenzen.CLI (Command Line Interface)Die FastEdge-CLI ist ein leistungsstarkes Tool, das Entwicklern und DevOps-Teams die direkte Interaktion mit FastEdge über eine Befehlszeilenschnittstelle ermöglicht. Diese Funktion vereinfacht Arbeitsabläufe, indem sie eine Reihe von Befehlen für das Deployment Management, die Überwachung der Performance sowie die Integration in bestehenden CI/CD-Pipelines bietet. Darüber hinaus unterstützt sie lokale Tests, mit denen Teams Deployment-Umgebungen replizieren und Änderungen in Echtzeit erproben können, bevor sie live gehen.Das bedeutet für Sie Folgendes:Effiziente Automatisierung: Verringern Sie menschliche Fehler durch die Automatisierung von Aktualisierungen, Skalierung und der Verwaltung von Konfigurationen.Nahtlose Integration: Optimieren Sie Ihre CI/CD-Pipelines mit FastEdge, um schnellere Entwicklungszyklen, kürzere Markteinführungszeiten und geringeren Verwaltungsaufwand zu ermöglichen.Verbesserte Kontrolle: Verwenden Sie die CLI, um Einstellungen und Deployments zu verwalten, und geben Sie Entwicklern die nötige Flexibilität, Prozesse an ihre individuellen Anforderungen anzupassen.Erhöhte Flexibilität: Testen und debuggen Sie Ihre Anwendungen lokal, um Änderungen vor der Bereitstellung zu validieren, Risiken zu reduzieren und bessere Ergebnisse zu erzielen.Optimierte Entwicklung: Vereinfachen Sie Routineaufgaben, damit sich Ihre Teams ganz auf Innovationen und auf die Verbesserung der Performance Ihrer Anwendungen konzentrieren können.Wenn Sie den Umgang mit FastEdge CLI kennenlernen und die vollständige Dokumentation lesen möchten, besuchen Sie das FastEdge CLI GitHub-Repository.Vorlagen für eine schnelle KonfigurationVordefinierte Vorlagen optimieren die Bereitstellung von FastEdge-Services, indem sie die Konfiguration für gängige Anwendungsfälle erheblich vereinfachen. Diese Vorlagen bieten mehrere entscheidende Vorteile für Nutzer. Die vordefinierten Optionen für Caching, Sicherheit und Lastausgleich erlauben eine schnelle und fehlerfreie Einrichtung, die viel Zeit bei der Bereitstellung spart. Durch standardisierte Konfigurationen für alle Bereitstellungen sorgen die Vorlagen für Konsistenz im gesamten System, was Fehler reduziert und die Stabilität erhöht. Obwohl die Vorlagen die genannten standardisierten Vorteile bieten, sind sie flexibel und können problemlos Ihren spezifischen Anforderungen angepasst werden. Indem sie es Ihnen ermöglichen, konsistente Anpassungen in Ihrer gesamten Netzwerkinfrastruktur vorzunehmen, vereinfachen sie sowohl die Skalierungs- als auch die Wartungsprozesse.Verbesserte Verwaltung im Gcore-KundenportalDas aktualisierte Gcore-Kundenportal bietet erweiterte Tools für die Verwaltung von FastEdge-Services. So können Partner und Wiederverkäufer Kundeneinstellungen besser kontrollieren und Probleme beheben.Die zentrale Verwaltungsschnittstelle erlaubt es Ihnen, Kundeneinstellungen schnell zu ändern. Das spart Zeit und vereinfacht die Konfigurationsprozesse für Ihren Kundenstamm. Neuen Kunden können Sie benutzerdefinierte Vorlagen zur Verfügung stellen, die einen einheitlichen und effizienten Prozess möglich machen, der das Onboarding beschleunigt. Die systemeigenen Diagnosen und Auswertungen in Echtzeit helfen Ihnen, Anwendungsprobleme schneller zu beheben und Serviceausfälle zu minimieren. Außerdem können mit den Verbesserungen die Serviceleistungen für mehrere Kunden einfach verwaltet und skaliert und gleichzeitig konsistente Konfigurationen für den gesamten Kundenstamm gewährleistet werden.Bleiben Sie über künftige FastEdge-Updates informiertDiese Updates – in Kombination mit FastEdge, dem erweiterten Funktionsumfang unserer serverlosen Edge-Computing-Lösung – machen es einfacher denn je, sichere, skalierbare und leistungsstarke Anwendungen zu implementieren. Freuen Sie sich also auf weitere Verbesserungen im nächsten Monat!

21 Oct 2025 Wir erweitern den Horizont: die neueste Expansion des Edge-Netzwerks von Gcore

Wir erweitern den Horizont: die neueste Expansion des Edge-Netzwerks von GcoreWir freuen uns, die neueste Expansion unseres Edge-Netzwerks an drei neuen Präsenzpunkten in Brüssel (Belgien), Helsinki (Finnland) und Phnom Penh (Kambodscha) zu verkünden. Diese neuen Standorte sind ein wichtiger Beitrag zu unserer fortlaufenden Mission, eine überragende Internetverbindung mit minimalen Latenzzeiten auf der ganzen Welt bereitzustellen.Brüssel, Belgien: Wir stärken das Herzstück EuropasBrüssel, Belgien | Foto von Jonathan Ricci auf UnsplashDie Stadt Brüssel, auch bekannt als die Hauptstadt Europas, spielt eine wichtige Rolle bei internationalen Angelegenheiten und der digitalen Vernetzbarkeit. Zu Beginn des Jahres 2023 waren in Belgien mehr als 11 Millionen Internetnutzer registriert. Die Internetverbreitung betrug zu diesem Zeitpunkt 94,5 % und wächst nach wie vor immer weiter. Kombiniert mit der Präsenz von bekannten Marken internationaler Unternehmen in Belgien stärkt dieser neue Präsenzpunkt das Digital Powerhouse im Herzen Europas.Unser neue Präsenzpunkt in Brüssel dient somit nicht nur als eine bedeutende Ergänzung zu unserem eigenen Netzwerk, sondern stellt auch einen wichtigen Schritt bei der Stärkung der Interneteffizienz in ganz Europa dar. Seit der Einführung konnten wir bereits eine deutliche Verbesserung der Netzwerkleistung verzeichnen. Das beweisen auch die Durchsatzzahlen: Seit der Bereitstellung des neuen Präsenzpunkts konnten die Werte der Konkurrenz nicht nur erreicht, sondern gar verdoppelt werden.Abbildung 1. Der Durchsatz von Gcore in Brüssel erreicht einen Spitzenwert von 16.000 KbpsHelsinki, Finnland: Antrieb der digitalen Exzellenz im NordenDer Dom in Helsinki bei Nacht | Foto von Tapio Haaja auf UnsplashDie Stadt Helsinki ist bereits für ihren technologischen Fortschritt und eine hohe Internetverbreitung bekannt, doch auch hier bietet unser neuer Präsenzpunkt eine weitere deutliche Verbesserung der digitalen Vernetzbarkeit. Finnland bleibt nach wie vor einer der digitalen Vorreiter Europas und prahlt mit einer beeindruckend hohen Zahl an mobilen Verbindungen, die mehr als 170 % der Gesamtbevölkerung entspricht.Die Einführung des neuen Präsenzpunkts geht Hand in Hand mit der fortschrittlichen digitalen Agenda des Landes, und die gezielte Annäherung von Inhalten an den Nutzer zeigte ganz klar ihre Wirkung: Seit der Einführung des neuen Präsenzpunkts am 10. Oktober verzeichneten lokale Internetbenutzer eine enorme Abnahme der Latenzzeit mit einer soliden RTT von 34,8 ms, was Gcores Position als ein führendes Netzwerk für die Bereitstellung von Inhalten in der Region festigt.Abbildung 2. Gcores RTT in Finnland nach der Einführung des neuen Präsenzpunkts sank auf 34,8 msPhnom Penh, Kambodscha: der Beginn einer neuen Ära der digitalen VernetzbarkeitPhnom Penh, Kambodscha | Foto von Paul Szewczyk auf UnsplashDie Einführung unseres Präsenzpunkts in Phnom Penh stellt einen Meilenstein im Zuge unserer Expansion in Südostasien dar. Die schnell wachsende Anzahl an Internetnutzern in Kambodscha liegt derzeit bei 67 % der Bevölkerung, also 714.000 Nutzern – eine Steigerung um knapp 7 % im Vergleich zum Vorjahr. Wir sind stolz, ein Teil der digitalen Explosion in Kambodscha zu sein.Dieser neue Präsenzpunkt hat bereits eine deutliche Wirkung gezeigt, indem er die Reaktionszeiten verkürzte und die Zuverlässigkeit verbesserte. Seit der Einführung unseres Präsenzpunkts im Oktober 2023 sank die durchschnittliche RTT (Round Trip Time) von ca. 38 ms auf unter 5 ms und die Durchsatzrate des Netzwerks von Gcore übertrifft derzeit oftmals die Durchsatzraten unserer Konkurrenten.Abbildung 3. Seit der Einführung des neuen Präsenzpunkts in Phnom Penh übertrifft die Durchsatzrate des Netzwerks von Gcore die Durchsatzraten der KonkurrenzWerden Sie ein Teil unseres wachsenden NetzwerksUnsere neuen Präsenzpunkte in Brüssel, Helsinki und Phnom Penh unterstreichen unser Engagement bei der Bereitstellung von schnellen, sicheren und zuverlässigen Internetdiensten auf der ganzen Welt. Werden Sie ein Teil von Gcore, begrüßen Sie mit uns gemeinsam diese neue Ära der Vernetzbarkeit und erleben Sie die Leistungsfähigkeit unseres erweiterten Edge-Netzwerks.

12 Dec 2023 Gcore für drei Streaming Media European Innovation Awards nominiert

Gcore für drei Streaming Media European Innovation Awards nominiertWir freuen uns sehr, bekanntgeben zu können, dass Gcore für die prestigeträchtigen Streaming Media European Innovation Awards 2023 nominiert wurde. Und das nicht nur in einer Kategorie, sondern in drei! Wir brauchen Ihre Stimmen, um den Sieg nach Hause zu bringen.Streaming Media European Innovation AwardsJedes Jahr führen die Streaming Media European Innovation Awards eine Umfrage durch, um die innovativsten und wegweisendsten Streaming-Lösungen in ganz Europa zu ermitteln und auszuzeichnen. Dass wir in drei Kategorien in die engere Wahl gekommen sind, unterstreicht unser Engagement für Innovation, Qualität und das nahtlose Streaming-Erlebnis, das wir anstreben.Gcore wurde in den folgenden Kategorien nominiert:🏅 Content Delivery & Distribution🏅 Encoding/Transcoding Solution🏅 Live Streaming Platform/ServiceDiese Nominierungen spiegeln das Engagement und die harte Arbeit unseres gesamten Teams bei Gcore wider. Es ist unsere Leidenschaft, erstklassige Streaming-Lösungen zu entwickeln, und es ist für uns eine Ehre, dass unsere Bemühungen von einem so renommierten Medienunternehmen anerkannt werden.Abstimmen für GcoreJetzt ist es an der Zeit, diese Auszeichnungen mit nach Hause zu nehmen! Wenn Sie Gcore gerne genutzt haben und an unsere Mission glauben, würden wir uns freuen, wenn Sie uns Ihre Stimme geben würden. Um abzustimmen, folgen Sie bitte diesem Link: Abstimmungsseite der Streaming Media European Innovation Awards 2023 (keine Registrierung erforderlich.) Die Abstimmung endet am 27. Juli, also warten Sie nicht länger.Gcores Nominierungskategorien finden Sie auf der AbstimmungsseiteVielen Dank für Ihre kontinuierliche Unterstützung. Sie sind es, unsere geschätzten Nutzer, die diesen Nominierungen Bedeutung verleihen. Mit Ihrer Unterstützung hoffen wir, den Sieg zu erringen und die Zukunft der Streaming-Technologie weiter zu gestalten. Auf die Innovation, den Fortschritt und – hoffentlich – den Sieg!

25 Jul 2023