Durch Virtualisierung können mehrere Betriebssysteme und Anwendungen auf einem einzigen physischen Server ausgeführt werden, wodurch die Hardwareressourcen optimiert und die Verwaltung vereinfacht werden. Es umfasst zwei miteinander verwobene Technologien: Container und virtuelle Maschinen. Während Container für ihre Geschwindigkeit, Effizienz und Portabilität bekannt sind, bieten VMs robuste Isolations- und Sicherheitsfunktionen. In diesem Artikel werden die Technologien erläutert und verglichen, damit Sie ihre Zweckmäßigkeit verstehen und eine fundierte Entscheidung für die Infrastrukturanforderungen Ihres Unternehmens treffen können.

Kurz und bündig: Was ist der Unterschied zwischen Containern und VMs?

Im Bereich der Virtualisierungstechnologien bieten Container und virtuelle Maschinen (VMs) unterschiedliche Ansätze für die Isolierung von Anwendungen, die Ressourcennutzung und die Systemarchitektur. Container nutzen die Virtualisierung auf Betriebssystemebene für hohe Leistung und effiziente Ressourcennutzung, während VMs auf Hardwareebene arbeiten und ein vollständiges Gastbetriebssystem für eine stärkere Isolierung kapseln. Diese grundlegenden architektonischen Unterschiede führen zu unterschiedlichen Niveaus bei Leistung, Startzeit und Ressourcennutzung.

Beide Technologien haben ihre eigenen Vor- und Nachteile, wenn es um den Einsatz in Unternehmen, Sicherheitsprotokolle und Skalierbarkeit geht. Um die Vor- und Nachteile sowie die Anwendungsfälle zu verstehen, müssen wir uns zunächst jede Technologie und ihre Architektur im Detail ansehen und dann am Ende des Artikels einen direkten Vergleich anstellen.

Was sind Container?

Container sind virtualisierte, isolierte Anwendungspakete. Sie enthalten alles, was zum Ausführen einer Software benötigt wird, einschließlich Code, Systemtools, Bibliotheken und Einstellungen (sogenannte Abhängigkeiten). Sie lösen das kritische Problem der Softwareentwicklung und -bereitstellung, das darin besteht, sicherzustellen, dass die Software in verschiedenen Computerumgebungen ordnungsgemäß ausgeführt werden kann. Dadurch wird die Software für die Endbenutzer zuverlässig, eine wesentliche Eigenschaft jeder Softwareversion. Um ihren Zweck zu erfüllen, sind Container portabel, d. h. sie können in verschiedenen Entwicklungsumgebungen ausgeführt werden, so dass Entwickler Software in verschiedenen Umgebungen testen können, ohne sich um Konflikte mit dem zugrunde liegenden System sorgen zu müssen.

Vorteile von Containern

Container haben sich aufgrund der folgenden Vorteile durchgesetzt:

- Schnelleres Starten: Container benötigen kein Betriebssystem, um zu starten. Das bedeutet, dass sie fast sofort starten können.

- Effiziente Ressourcennutzung: Container nutzen den Kernel ihres Host-Betriebssystems (den Kernteil des Betriebssystems des Computers). Das macht sie leichtgewichtig und ressourceneffizient, da sie nicht die zusätzlichen Kosten einer separaten Betriebssysteminstallation für jeden Container erfordern. Das spart Platz und Ressourcen und sorgt für einen schnellen und reibungslosen Ablauf.

- Portabilität: Container kapseln ganze Anwendungen und ihre Abhängigkeiten in einer einzigen Datei, so dass Entwickler Anwendungen nur einmal erstellen und sie dann in mehreren Umgebungen ausführen können. Diese Portabilität gewährleistet ein konsistentes Verhalten, wenn Container zwischen Entwicklungs-, Test- und Produktionsumgebungen verschoben werden.

- Isolation: Mehrere Container (und ihre Abhängigkeiten) können sich einen einzigen Betriebssystem-Kernel teilen und dabei so isoliert laufen, dass der Ausfall eines Containers die Funktion der anderen in derselben Umgebung nicht beeinträchtigt. Spezielle Sicherheitstools, wie z.B. Tools zur Isolierung von Betriebssystemen, stehen ebenfalls zur Verfügung, um fehlerhafte Teile von Containern zu lokalisieren und effizient zu beheben.

- Skalierbarkeit: Sie können mehrere ähnliche Container ausführen, um mehrere Anwendungsinstanzen gleichzeitig zu erstellen. Die Containerisierung ermöglicht es auch, nur die Container auszuführen, die eine Anwendung zu einem bestimmten Zeitpunkt benötigt, um effizient zu funktionieren. So können Container je nach Anwendungslast nach oben oder unten skaliert werden. Diese Funktionen machen Container hochgradig skalierbar und kosteneffizient.

Wie funktionieren Container?

Container isolieren Anwendungen und ihre Abhängigkeiten in tragbaren, in sich geschlossenen Einheiten, die überall eingesetzt werden können. Ein Container-Image – eine unveränderliche Datei mit ausführbarem Code – erstellt einen Container. Container-Images werden mit einer Dockerdatei (oder ähnlichen Konfigurationsdateien) erstellt und in Container-Repositories gespeichert. Wenn ein Container instanziiert wird, wird das Image aus dem Repository auf den Host-Rechner gezogen. Danach wird das Image verifiziert und alle fehlenden Ebenen werden aus der Registry geholt. Sobald die Umgebung eingerichtet ist, startet die Laufzeitumgebung den Container und führt den im Image definierten Befehl aus.

Aber was ist eine Laufzeit?

Eine Container-Laufzeitumgebung ist ein Softwarepaket, das das Host-Betriebssystem eines Containers nutzt, um den Container auszuführen. Es schafft die notwendige Umgebung für die Ausführung des Containers, einschließlich der erforderlichen Namensräume und Kontrollgruppen (in der Regel als cgroups bezeichnet). Sowohl Namensräume als auch cgroups erleichtern die Ressourceneffizienz: Namensräume organisieren den Code in Gruppen, und cgroups begrenzen die Nutzung der Ressourcen. Der Container läuft dann innerhalb der isolierten Umgebung und nutzt die vom Host-Betriebssystem bereitgestellten Ressourcen und Namensräume.

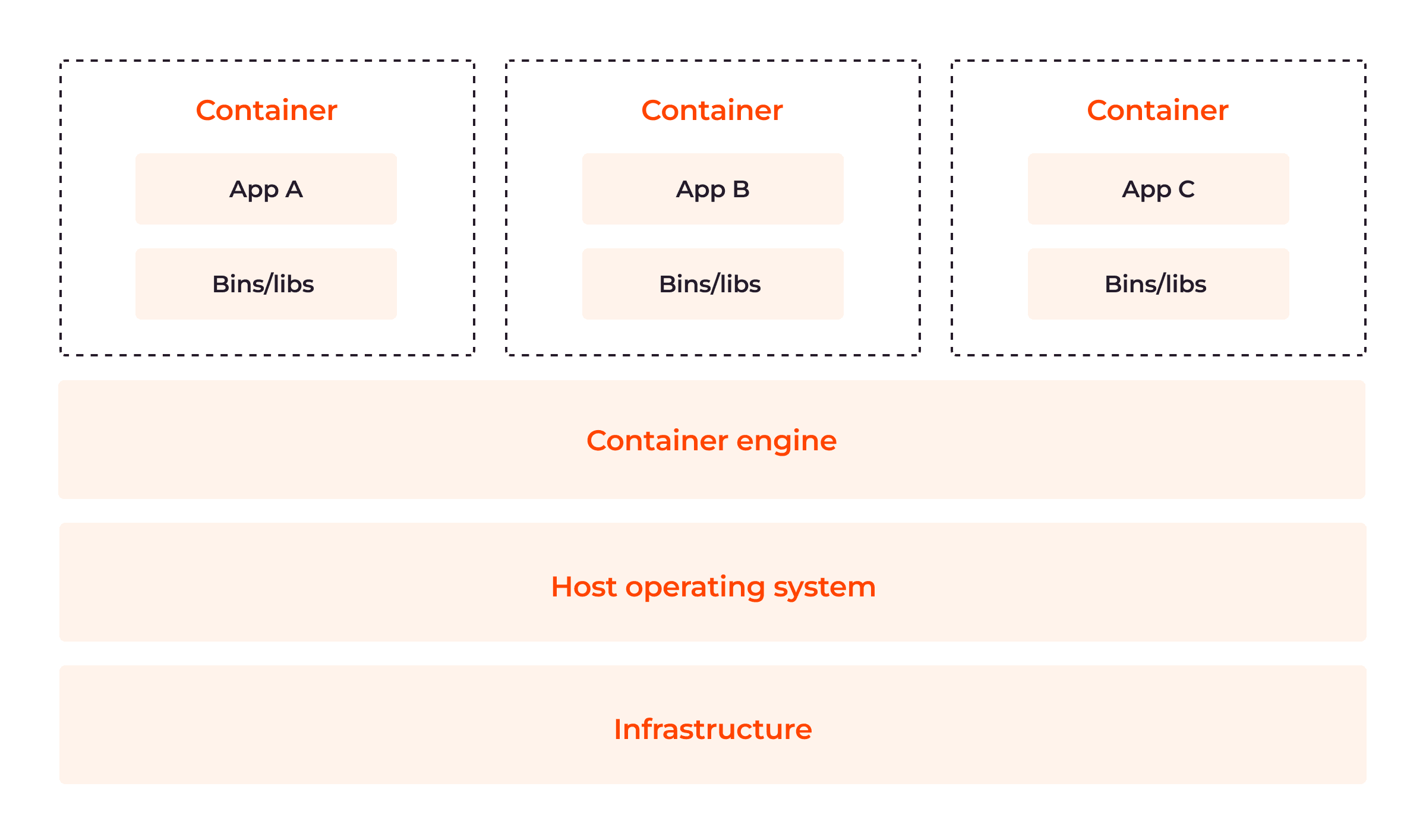

Container-Architektur

Container haben sechs Hauptkomponenten: Container-Laufzeiten, Container-Images, Registries, Container-Orchestrierungsplattformen, Kontrollgruppen und Namensräume. Werfen wir einen Blick auf jeden einzelnen.

Container-Laufzeiten

Container-Laufzeiten oder Engines sind Softwarekomponenten, die für das Abrufen von Container-Images aus einer Registry, die Einrichtung der erforderlichen Ausführungsumgebung, die Verwaltung und Ausführung von Containern auf einem Host-Rechner und die Überwachung von Containern innerhalb der Cluster-Umgebung zuständig sind. Die Container-Laufzeitumgebung orchestriert auch die Erstellung und Ausführung von Containern.

Container-Images

Container-Images sind kompakte, unveränderliche Snapshots, die Anwendungscodes, Abhängigkeiten, Konfigurationsdateien, Bibliotheken und Laufzeitumgebungen enthalten, die für die Ausführung von Anwendungen erforderlich sind. Images haben eine oder mehrere Ebenen, die auf einem übergeordneten oder Basis-Image aufbauen. Sie werden in der Regel mit Hilfe von Dockerfiles erstellt. Dabei handelt es sich um eine Textdatei, die die Anweisungen zur Erstellung eines mehrschichtigen Images enthält, das die Anwendung und ihre Abhängigkeiten darstellt.

Die Ebenen der Container-Images machen ihre Komponenten und Konfigurationen wiederverwendbar. Die Entwickler müssen also nicht jedes Mal, wenn Bilder benötigt werden, neue erstellen. Bei optimalem Aufbau können diese Ebenen dazu beitragen, die Containergröße zu minimieren und die Leistung zu verbessern.

Images (und andere Artefakte) bilden Repositorys. Container-Images sind mit Namen und Tags versehen, so dass Sie sie leicht verschieben und herausziehen können. Ein Repository und ein Tag definieren den Namen eines Images und ermöglichen die einfache gemeinsame Nutzung von Container-Images. Ein einziges Repository kann mehrere Container-Images enthalten. Um diese schreibgeschützten Images zu ändern, müssen Entwickler eine Ebene erstellen, die alle Änderungen über dem übergeordneten Image enthält.

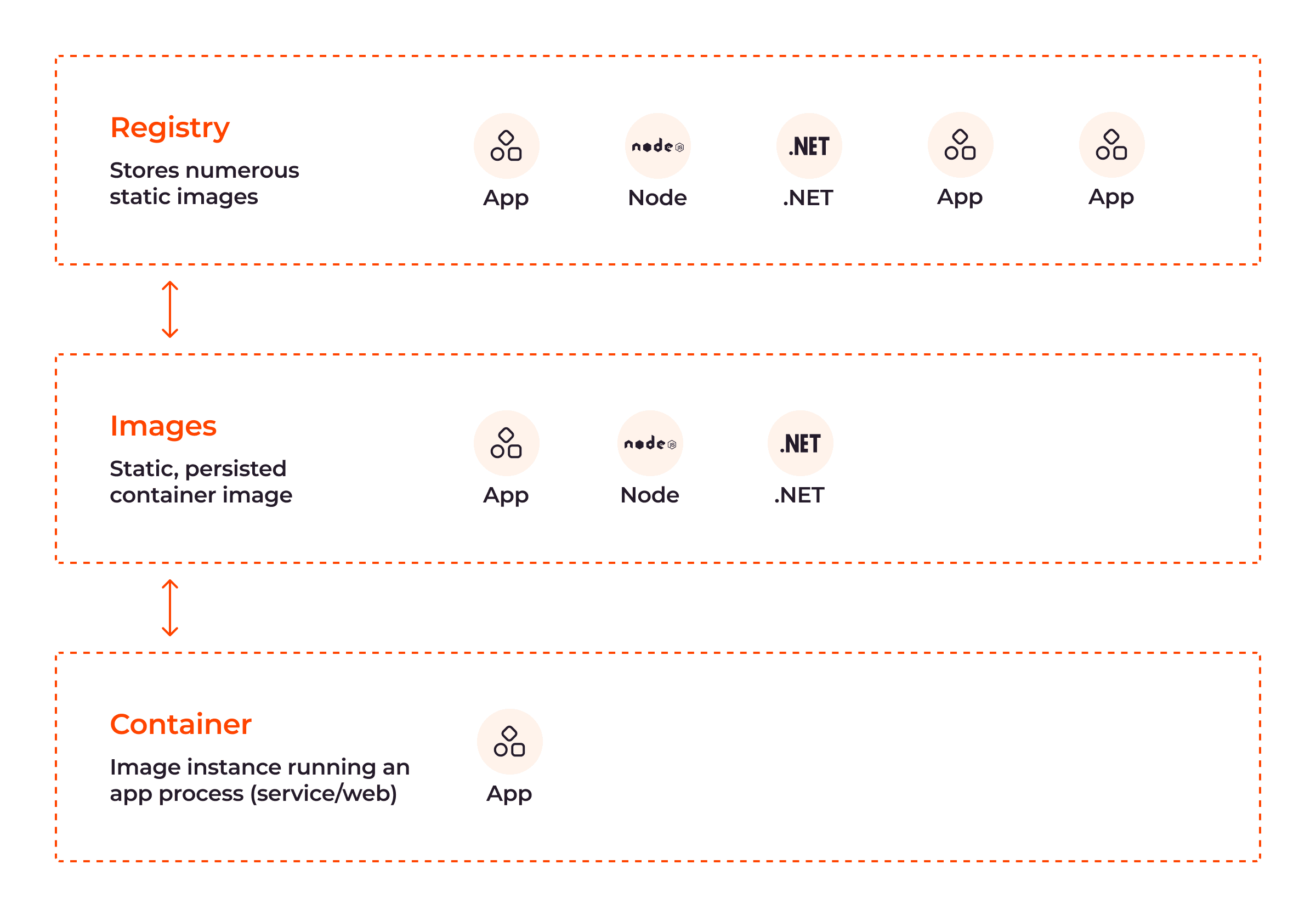

Wie in der obigen Abbildung zu sehen ist, werden Container-Images in Registries gespeichert und können auf einen Host-Rechner gezogen werden, um Container zu erstellen und auszuführen.

Registries

Registries sind zentrale Repositorys, die Container-Images speichern und verteilen, um deren Effizienz zu gewährleisten. Registries können öffentlich oder privat sein.

- Öffentlich: Dies ist eine umfangreiche Sammlung von vorgefertigten Container-Images, die Entwickler verwenden können. DockerHub, ein allgemeiner Katalog von Container-Images, ist ein hervorragendes Beispiel für eine öffentliche Container-Registry.

- Privat: Dies ist eine Registry, in der Unternehmen ihre eigenen benutzerdefinierten Container-Images speichern und verwalten, um ihre Privatsphäre zu schützen und eine bessere Kontrolle über sie zu haben.

Wenn ein Image aus einer Registry gezogen wird, wird es lokal auf dem Hostrechner gespeichert, um sicherzustellen, dass Container ohne Netzwerkverbindung zur Registry erstellt werden können.

Container-Orchestrierung-Plattformen

Container-Orchestrierung ist ein Ansatz zur Automatisierung und Verwaltung der Bereitstellung von Containern, um die Anwendungsleistung zu verbessern. Plattformen wie Kubernetes werden verwendet, um die Bereitstellung, Skalierung und Planung von Containern durch verschiedene Funktionen wie automatische Skalierung, Load Balancing und Zustandsüberwachung zu automatisieren.

Die Container-Registry, die Laufzeit und die Orchestrierungsplattform sind drei wichtige Komponenten der Container-Orchestrierung, die für die Verwaltung von Containern während des gesamten Lebenszyklus der Softwareentwicklung erforderlich sind.

Kontrollgruppen (cgroups)

Die Kontrollgruppe ist eine der beiden Hauptfunktionen von Containern im Kernel-Betriebssystem, die andere ist der Namensraum (siehe unten). cgroups bietet die folgenden Funktionen:

- Ressourcenzuweisung: cgroups begrenzt und priorisiert die Ressourcen (einschließlich CPU-Nutzung, Arbeitsspeicher, Festplatten-E/A und Netzwerkbandbreite), die Containern zugewiesen werden.

- Prozesskontrolle: Da sie große Mengen von Prozessen gleichzeitig instanziieren können, sind Container anfällig für Angriffe. Dies geschieht, um das Volumen der Prozesse zu beeinflussen und die Container-Ressourcen zu erschöpfen. cgroups kann verwendet werden, um die Anzahl der laufenden Prozesse zu starten, zu stoppen oder einzuschränken und so Angriffe zu verhindern und die Anwendungsleistung zu verbessern.

Namensräume

Namensräume sorgen für eine Isolierung auf Prozessebene innerhalb des Betriebssystems und stellen sicher, dass nur das Kernel-Betriebssystem gemeinsam genutzt wird; alle anderen Ressourcen sind zwischen Containern isoliert. Namensräume ermöglichen es Containern, mit ihren eigenen Dateisystemansichten, Netzwerkstapeln, Prozessbäumen und Benutzerrechten zu arbeiten. Container benötigen ihre eigenen Systemansichten, Netzwerkstapel, Prozessbäume und Benutzerrechte, um sich von anderen Systemen innerhalb der Umgebung zu isolieren. So wird Containern in der Regel nur ein begrenzter Zugriff auf Geräte auf dem Host gewährt, aber mit erhöhten Rechten können sie auf dieselben Funktionen wie das Host-Betriebssystem zugreifen, wodurch die Isolierung der Container gewährleistet wird.

Jeder Container hat einen zugehörigen Namensraum, der die Illusion von Individualität vermittelt. Es gibt vier große Namensräume, die für die Zuweisung von Ressourcen an Container verwendet werden:

| Namensraum | Funktion |

| PID Namensraum | Stellt sicher, dass jeder Container seine eigene Prozess-ID hat |

| Netzwerk-Namensraum | Erlaubt Containern, ihre eigene Netzwerkschnittstelle, IP-Adresse und Routing-Tabelle zu haben |

| Bereitstellung eines Namensraums | Ermöglicht Containern ihr eigenes Root-Dateisystem und vermeidet Konflikte mit Dateien aus anderen Containern |

| Benutzer-Namensraum | Ermöglicht die Isolierung von Benutzern und Gruppen |

Die folgende Abbildung zeigt die Beziehung zwischen den oben erläuterten Komponenten der Container-Architektur:

Anwendungsfälle für Container

Container erfreuen sich aufgrund ihrer Vielseitigkeit und Anwendbarkeit in verschiedenen Branchen großer Beliebtheit. Lassen Sie uns einige ihrer bemerkenswerten Anwendungsfälle näher betrachten.

Microservices-Sicherheit

Microservices sind ein architektonischer Ansatz für die Softwareentwicklung und -bereitstellung, bei dem Anwendungen aus kleinen unabhängigen und spezialisierten Diensten bestehen, die über APIs (Application Programming Interfaces) und REST-Schnittstellen (Representational State Transfer) lose miteinander verbunden sind. Microservices, die direkt auf einem Host-Betriebssystem bereitgestellt werden, sind weniger sicher, da sich Sicherheitsschwachstellen leicht in der Betriebssystemschicht ausbreiten können. Im Gegensatz dazu sind containerisierte Microservices sicherer und effizienter, da Container die Angriffsfläche reduzieren, unabhängiges Patching ermöglichen und Kontrolle über die Ressourcenzuweisung bieten.

Anwendungspaket und -vertrieb

Da ein Container-Image die Anwendung und ihre Abhängigkeiten beherbergt, ist es einfach, sie in verschiedenen Umgebungen einzusetzen. Sie müssen lediglich eine YAML-Deklaration des Container-Images erstellen und es in einer beliebigen Umgebung bereitstellen. Damit entfällt das „funktioniert auf meinem Rechner“-Problem, das bei herkömmlichen Implementierungen häufig auftritt.

Kontinuierliche Integration und kontinuierliche Bereitstellung (CI/CD)

Entwickler setzen Container-Images ein, um CI/CD zu erleichtern. CI ist die Methode, kontinuierlich Änderungen am Softwarecode vorzunehmen und diesen in einem automatisierten Prozess auf seine semantische Korrektheit zu testen. Eingehende Integrationstests können teuer sein, was den Mehrwert der Containerisierung unterstreicht.

Indem sie ihre Anwendungen in Containern zusammenfassen, können Entwickler sie in verschiedenen Phasen des Entwicklungszyklus aus Images instanziieren. Dieser Ansatz, der von Unit-Tests über Staging bis hin zur Produktion reicht, spart die mit der Einrichtung und dem Betrieb von CI/CD-Servern verbundenen Kosten und steigert gleichzeitig die Effizienz.

Hybride und Multicloud-Umgebungen

Mit Containern lassen sich Anwendungen problemlos über verschiedene Cloud-Anbieter oder lokale Infrastrukturen hinweg migrieren, ohne dass eine umfangreiche Neukonfiguration der Anwendung erforderlich ist.

Maschinelles Lernen, Edge Computing und Internet der Dinge

Dies ist ein weiterer wichtiger Anwendungsfall von Containern. Container werden zunehmend für Edge Computing und das Internet der Dinge (IoT) eingesetzt, da sie eine unkomplizierte Bereitstellung ermöglichen und verschiedene Dienste in einzelnen Containern ausgeführt werden können, wodurch die Möglichkeit verringert wird, dass Probleme bei einem Dienst andere Dienste beeinträchtigen. Darüber hinaus können Datenwissenschaftler mit Hilfe von Container-Umgebungen sicherstellen, dass Experimente reproduzierbar sind, ihre Arbeit leicht weitergeben und konsistente Entwicklungsumgebungen für maschinelles Lernen, künstliche Intelligenz und kollaborative Projekte schaffen.

Nachdem wir uns nun mit Containern beschäftigt haben, wenden wir uns nun den virtuellen Maschinen zu.

Was sind virtuelle Maschinen?

Eine virtuelle Maschine (VM) ist eine virtualisierte Emulation eines gesamten Computersystems innerhalb eines Host-Rechners, einschließlich seiner Hardware und seines Betriebssystems. Sie bietet eine Umgebung, die das Gastbetriebssystem und die Anwendungen von der zugrunde liegenden Hardware und dem Host-Betriebssystem isoliert, um zu verhindern, dass Schwachstellen einer Komponente die gesamte Cloud-Umgebung beeinträchtigen. Eine VM basiert auf einem Hypervisor, einer Software-Ebene, die für die Erstellung von VMs und die Verwaltung/Zuweisung der physischen Ressourcen eines Host-Rechners an virtualisierte Gastsysteme auf der Grundlage ihrer relativen Bedeutung verantwortlich ist.

Vorteile von virtuellen Maschinen

Virtuelle Maschinen bieten mehrere Vorteile:

- Vollständige Isolierung: Eine VM führt ihr eigenes Gastbetriebssystem und ihre eigene Anwendung innerhalb ihrer isolierten Umgebung so aus, dass sichergestellt ist, dass die Anwendungen einer VM die Anwendungen einer anderen VM nicht beeinträchtigen oder beeinflussen.

- Sicherheit: VMs bieten aufgrund ihrer vollständigen Isolierung starke Sicherheitsgrenzen. Kompromittierte Anwendungen oder Schwachstellen innerhalb einer VM sind in der Regel auf diese spezielle VM beschränkt und wirken sich nicht auf andere VMs oder das Host-System aus. Diese Isolierung trägt zum Schutz sensibler Daten bei und mindert die mit einer gemeinsam genutzten Infrastruktur verbundenen Sicherheitsrisiken.

- OS-Flexibilität: VMs ermöglichen es, verschiedene Betriebssysteme – darunter verschiedene Versionen von Windows, Linux und macOS – auf derselben physischen Hardware laufen zu lassen. Diese Flexibilität ermöglicht es Unternehmen, Anwendungen auszuführen, die bestimmte Betriebssysteme oder die Kompatibilität von Legacy-Software erfordern.

- Ressourcenpartitionierung: VMs ermöglichen die Partitionierung von physischen Ressourcen wie CPU, Arbeitsspeicher und Festplatten zwischen verschiedenen virtuellen Maschinen. Das erleichtert die effiziente Verwaltung der Workloads.

- Snapshot-Funktionen: VMs bieten die Möglichkeit, Snapshots zu erstellen, die den Zustand einer VM zu einem bestimmten Zeitpunkt festhalten. Diese Snapshots können für Datensicherungen, Notfallwiederherstellungen oder Tests verwendet werden.

- Migrationsfunktionalität: VMs ermöglichen eine nahtlose Migration zwischen Host-Maschinen ohne Unterbrechung der Dienste, so dass IT-Teams Workloads verschieben oder zwischen Servern und Maschinen wechseln können. Eine Migration wird in der Regel durchgeführt, wenn die VM-Hostsysteme, einschließlich Software und Hardware, gepatcht oder aktualisiert werden müssen.

- Hardware-Abstraktion: VMs bieten Hardware-Abstraktion, indem sie physische Hardware überflüssig machen, was dazu beiträgt, die Softwarekompatibilität zwischen verschiedenen Servern zu gewährleisten, da VMs Anwendungen vor unterschiedlichen Hardware-Konfigurationen schützen. Das hilft, Kosten für die physische Speicherung zu sparen.

Wie funktionieren virtuelle Maschinen?

VMs arbeiten als vollständig isolierte Gastsysteme mit ihren eigenen Betriebssystemen und Anwendungen. Sie nutzen den Hypervisor, um mehrere isolierte virtuelle Umgebungen auf einem einzigen physischen Host zu erstellen und zu verwalten. Wenn eine virtuelle Maschine eingeschaltet wird, fängt der Hypervisor die Anweisungen des Gastbetriebssystems ab und überträgt sie auf die entsprechende physische Hardware.

Ermöglicht wird dies durch Hardware-Virtualisierungstechniken wie Binärübersetzung und Hardware-gestützte Virtualisierung. Binärübersetzung ist eine Softwarevirtualisierungstechnik, bei der ein Interpreter den binären Maschinensprachcode einer Anwendung in den des Host-Betriebssystems übersetzt. Bei der Hardware-gestützten Virtualisierung werden die physischen Komponenten eines Computers genutzt, um die Software-Architektur zu unterstützen, die VMs benötigen, um richtig zu funktionieren. Beide Verfahren helfen dabei, die Kommunikation zwischen VMs und dem Host-Betriebssystem angemessen zu verknüpfen und zu erleichtern.

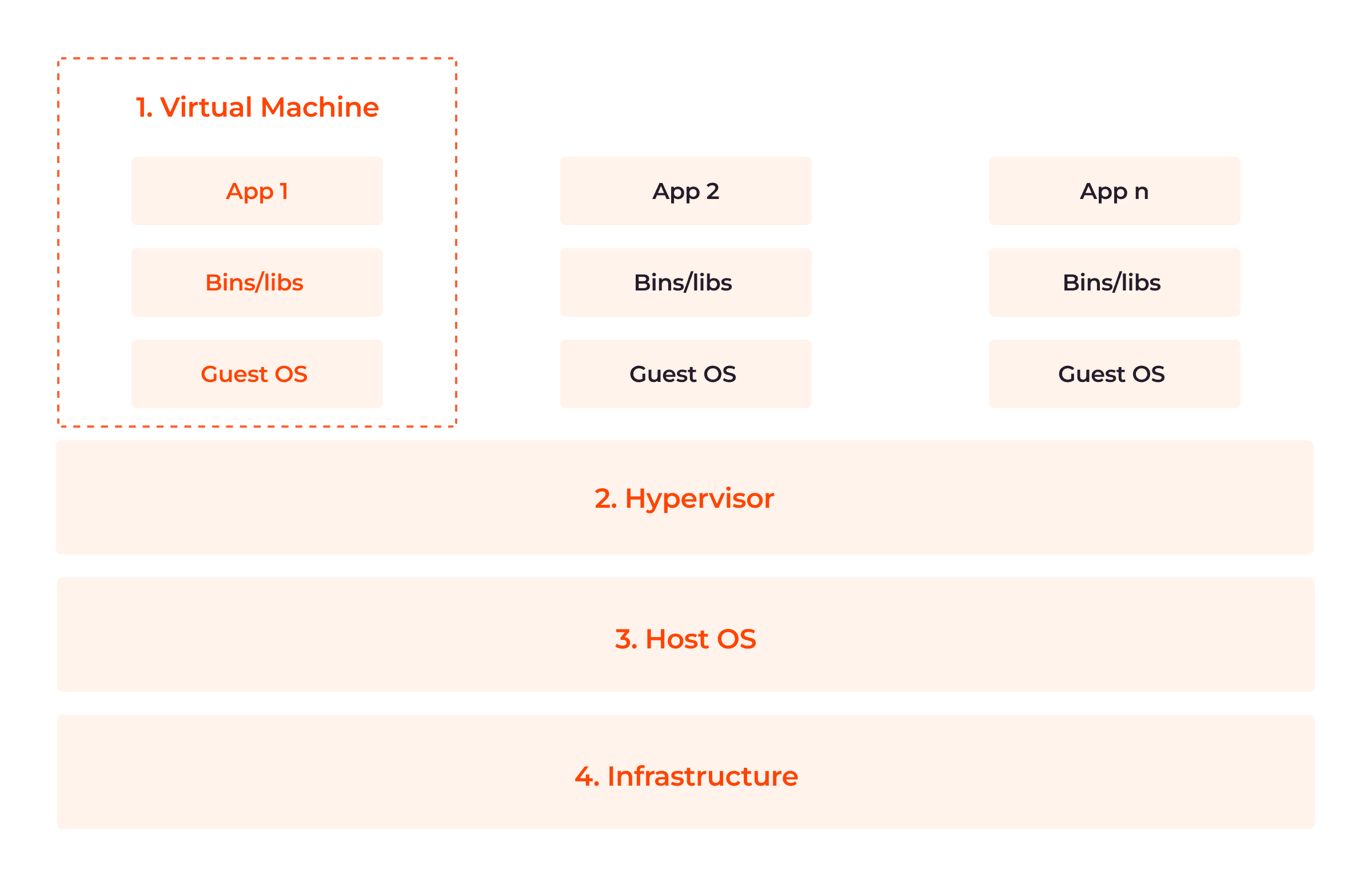

Architektur der virtuellen Maschine

VMs werden auf physischen Maschinen aufgebaut. Ihre Hauptkomponente ist ein Hypervisor, ein Host-Server, der VMs den Zugriff auf die benötigten Rechenressourcen ermöglicht. Die folgende Abbildung zeigt die vier Teile der VM-Architektur.

Gehen wir nun auf diese vier Komponenten ein.

1. Virtuelle Maschine (App, Bins/Libs, Gastbetriebssystem)

Zu den Komponenten einer virtuellen Maschine gehören virtualisierte Anwendungen und Bibliotheken, die einem Gastbetriebssystem präsentiert werden. Jede virtuelle Maschine hat ihr eigenes Gastbetriebssystem, das sich voneinander unterscheiden kann, so dass mehrere Betriebssysteme auf der gleichen Infrastruktur koexistieren können.

2. Hypervisor

Ein Hypervisor, auch bekannt als Virtual Machine Monitor (VMM), ist eine Software-Ebene, die die Erstellung und Verwaltung von virtuellen Maschinen (VMs) auf der physischen Host-Maschine/Infrastruktur ermöglicht. Es gibt zwei Arten von Hypervisors:

- Typ 1 (Bare-Metal-Hypervisoren), die direkt auf der Hardware des Host-Rechners laufen, ohne dass ein zugrunde liegendes Betriebssystem erforderlich ist. Sie haben direkten Zugriff auf die Hardware-Ressourcen und verwalten die virtuellen Maschinen auf einer niedrigen Ebene.

- Typ 2-Hypervisors laufen als Anwendungen auf dem vorhandenen Betriebssystem. Sie verlassen sich auf das Host-Betriebssystem, um die Hardware-Ressourcen zu verwalten, und bieten eine Virtualisierungsebene darüber.

3. Host-Betriebssystem

Das Host-Betriebssystem steht zwischen dem Hypervisor und der Infrastruktur. Sie sorgen für eine Isolierung zwischen der virtuellen Maschine und den Komponenten der Infrastruktur, indem sie den Datenfluss von der einen zur anderen Seite begrenzen. Das erhöht die Sicherheit für Hosts und Gastsysteme.

4. Infrastruktur

Die Infrastruktur ist die zugrunde liegende Hardware, auf der virtuelle Maschinen erstellt und ausgeführt werden. Sie stellt die notwendigen Rechenressourcen wie CPU, Arbeitsspeicher, Speicher und Netzwerk zur Verfügung.

Wie werden virtuelle Maschinen genutzt?

Virtuelle Maschinen werden in verschiedenen Branchen und Anwendungsfällen eingesetzt, z. B:

Unterstützung von Legacy-Anwendungen

Virtuelle Maschinen werden häufig verwendet, um ältere Anwendungen zu unterstützen und zu pflegen, die ursprünglich für ein älteres Betriebssystem oder für bestimmte Hardwarekonfigurationen entwickelt wurden. Durch die Ausführung von Legacy-Anwendungen auf virtuellen Maschinen können Unternehmen die Funktionen und Abhängigkeiten dieser Anwendungen beibehalten und gleichzeitig ihre zugrunde liegende Infrastruktur modernisieren.

Mandantenfähigkeit und Cloud Computing

VMs werden häufig in Cloud-Umgebungen eingesetzt, in denen mehrere Kunden dieselbe physische Infrastruktur nutzen. Denn sie sorgen für Kosteneffizienz und bieten Isolierung, Sicherheit und Anpassungsfähigkeit, während sie die Ressourcenauslastung für den Cloud-Anbieter maximieren.

Entwicklungsumgebungen

VMs bieten bequeme und isolierte Umgebungen für Entwickler, die an verschiedenen Projekten mit unterschiedlichen Softwareanforderungen arbeiten. Es können mehrere VMs eingerichtet werden, auf denen jeweils ein anderer Entwicklungs- oder Test-Stack läuft, was die Einrichtung, das Experimentieren und die Reproduzierbarkeit erleichtert.

Testen und Debugging

VMs bieten eine kontrollierte und reproduzierbare Umgebung für das Testen und Debuggen von Software. Tester können mehrere VM-Snapshots erstellen, um verschiedene Punkte im Softwaretestprozess festzuhalten, was Rollbacks, Fehlerreproduktion und Debugging erleichtert. Bei Rollbacks werden VMs in frühere Zustände zurückversetzt, um Fehler in aktuellen Zuständen zu löschen (oder zu reduzieren), und bei der Fehlerreproduktion wird ein Fehler in einer Software reproduziert, um zu sehen, wie er überhaupt entstanden ist. Beide Verfahren erleichtern das Debugging, das Patching und das Abrufen von Daten. VMs bieten eine bequeme Möglichkeit, die Kompatibilität von Software mit verschiedenen Betriebssystemen zu testen, sodass weniger physische Systeme benötigt werden.

Sicherheitsforschung und Notfallwiederherstellung

VMs werden für die Sicherheitsforschung sowie für die Analyse von Schwachstellen und Malware eingesetzt. Forschende können potenziell schädliche Anwendungen oder Websites innerhalb von VMs isolieren und analysieren, um Schäden an Hostsystemen oder Netzwerken zu verhindern.

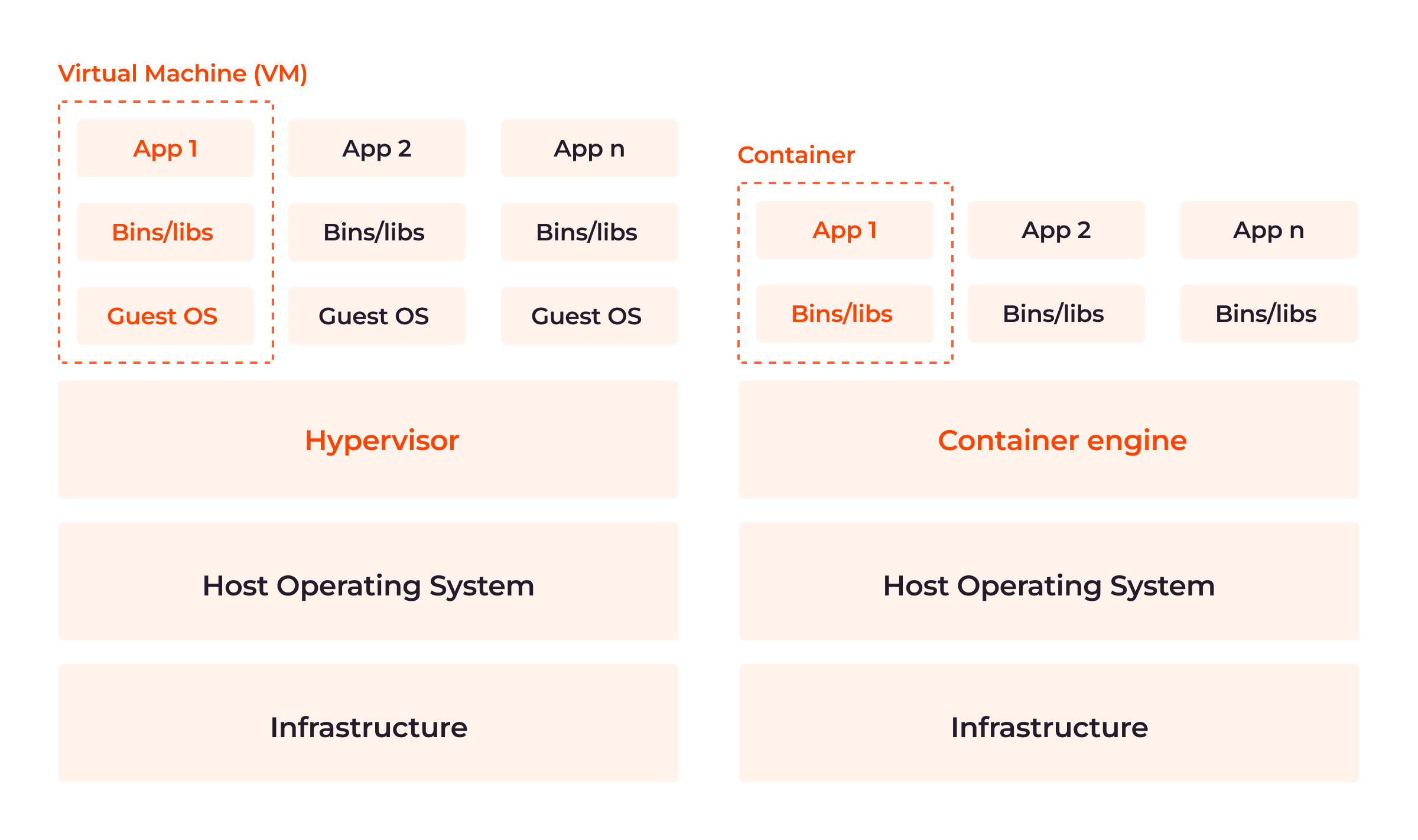

Was sind die Unterschiede zwischen Containern und virtuellen Maschinen (VMs)?

Obwohl beide leistungsfähig und effizient sind, hat die eine einen Vorteil gegenüber der anderen. Wie in der Abbildung unten zu sehen ist, besteht der größte architektonische Unterschied zwischen Containern und VMs im Vorhandensein oder Fehlen eines Gastbetriebssystems in der Virtualisierungsebene.

In der folgenden Tabelle finden Sie einen direkten Vergleich:

| Features | Container | Virtuelle Machinen |

| Architektur | Virtualisierungstechnologie auf Anwendungs- oder Betriebssystemebene. Container teilen sich den Kernel des Host-Betriebssystems, haben aber separate Benutzerbereiche. | Virtualisierungstechnologie auf Infrastruktur- oder Hardwareebene. Jede VM hat ihren eigenen Kernel, ihr eigenes Dateisystem und ihre eigene Speicherzuweisung. |

| Leistung | Bessere Leistung als VMs, da sie den Kernel des Host-Betriebssystems gemeinsam nutzen. Geringerer Aufwand und verbesserte Leistung. | Geringere Leistung im Vergleich zu Containern aufgrund des Aufwands, der durch die Ausführung eines vollständigen Gastbetriebssystems neben dem Hostbetriebssystem entsteht. |

| Ressourcennutzung | Effiziente Ressourcennutzung, da die Ressourcen des Hosts direkt genutzt werden. | Gegebenenfalls weniger effizient. Benötigen dedizierte Ressourcen für jede virtuelle Instanz, einschließlich eines separaten Gastbetriebssystems. |

| Latenz | Niedrigere Latenz, da sie direkt auf die Host-Hardware zugreifen und die Virtualisierungsebenen umgehen. | Einführung zusätzlicher Virtualisierungsebenen, die im Vergleich zu Containern zu einer höheren Latenz führen. |

| Startzeit | Bieten nahezu sofortige Startzeiten. | Längere Startzeiten, weil sie für jede Instanz ein komplettes Gastbetriebssystem booten müssen. |

| Isolation | Verwenden eine Isolierung auf Betriebssystemebene, die nicht so stark ist wie eine Virtualisierung auf Hardwareebene. | Vollständige Isolierung, da jede VM auf einem eigenen Hypervisor läuft. |

| Portabilität | Hochgradig portabel, was ein konsistentes Verhalten über verschiedene Systeme hinweg ermöglicht. | Weniger portabel, da sie aufgrund von Unterschieden in der Hardware und den Betriebssystemversionen Konfigurationsänderungen erfordern können, um in verschiedenen Umgebungen zu funktionieren. |

| Sicherheit | Potenzielle Sicherheitslücken durch den gemeinsamen Kernel des Host-Betriebssystems. Laufzeiten bieten Features wie Namensräume und Kontrollgruppen, um Sicherheitsrisiken zu minimieren. | Höheres Sicherheitsniveau durch starke Isolierung zwischen den einzelnen VMs. |

| Flexibilität | Größere Flexibilität bei der Ressourcenzuweisung und Skalierung. | Begrenzte Flexibilität; sie erfordern eine feste Zuweisung von Ressourcen. Änderungen an der Ressourcenzuweisung erfordern eine Anpassung der VM-Konfiguration. |

| Dichte | Aufgrund ihrer kompakten Größe können Container dichter auf einem Host-Rechner gepackt werden. | Weniger dicht aufgrund des Ressourcenaufwands. |

| Effizienz | Effizienter bezüglich Speicherplatz und Speichernutzung. | Erfordern zusätzlichen Speicherplatz und Arbeitsspeicher, da jede Instanz neben der Anwendung ein vollständiges Gastbetriebssystem benötigt. |

| Bereitstellungskomplexität | Vereinfachter Bereitstellungsprozess mit Container-Images | Komplexerer Bereitstellungsprozess, der die Bereitstellung und Konfiguration eines Gastbetriebssystems auf jeder virtuellen Instanz umfasst. |

| Anwendungsfälle | Gut geeignet für Microservices-Architektur, kontinuierliche Integration/kontinuierliche Bereitstellung, Skalierung von Anwendungen und Verwaltung verteilter Systeme. | Gemeinsam verwendet für die Ausführung von Legacy-Anwendungen, das Testen verschiedener Betriebssysteme, die Erstellung isolierter Betriebssystemumgebungen und Entwicklungs-Sandboxen. |

Die Wahl zwischen Containern und virtuellen Maschinen

Obwohl sowohl Container als auch VMS die Anwendungsentwicklung und -bereitstellung revolutioniert haben, hängt Ihre Wahl vom spezifischen Anwendungsfall, den Leistungsanforderungen und dem Isolierungsbedarf Ihrer Anwendungen ab. Container und VMs können mit Containern kombiniert werden, die innerhalb von VMs laufen, um die Vorteile beider Technologien zu nutzen. Dazu erstellen Sie eine virtuelle Maschine mit einer bestimmten Hardwarekonfiguration und installieren darin ein Betriebssystem. Dann installieren Sie eine Container-Laufzeit auf dem Betriebssystem.

Es ist jedoch von entscheidender Bedeutung, dass sich Container besser für moderne Praktiken und Anwendungsfälle eignen und die Portabilität bieten, die für Multi-Cloud-Umgebungen wichtig ist. So sind Container beispielsweise kompakter und verbrauchen viel weniger Ressourcen als virtuelle Maschinen. Wenn ein physischer Server nur 10 virtuelle Maschinen beherbergen kann, könnte er 20 oder mehr Container beherbergen.

Fazit

Virtualisierung erfährt einen rasanten Anstieg sowohl in der Popularität als auch in der Marktgröße. Laut Statista wird ihr Wert derzeit auf 40-62 Milliarden Dollar geschätzt und soll bis 2027 über 120 Milliarden Dollar an Umsatz erreichen. Da die Konkurrenz immer stärker wird, kann die Wahl der richtigen Virtualisierungstechnologie den Entscheidungsträgern einen Wettbewerbsvorteil gegenüber ihren Wettbewerbern verschaffen.

Gcores Managed Kubernetes minimiert die Komplexität der Nutzung von Containern und ermöglicht es Unternehmen, containerisierte Anwendungen mühelos zu orchestrieren und dabei Skalierbarkeit, Hochverfügbarkeit und eine vereinfachte Verwaltung zu gewährleisten – und das alles ohne Kompromisse bei Sicherheit oder Leistung einzugehen.

Ähnliche Artikel

Melden Sie sich für unseren Newsletter an

Erhalten Sie die neuesten Branchentrends, exklusive Einblicke und Gcore-Updates direkt in Ihren Posteingang.